Lars系统开发

(Load balance And Remote service schedule System)

ChangLog

| 作者 | 更新内容 | 更新时间 |

|---|---|---|

| 刘丹冰 | Add-项目概述 | 2019/9/03 |

| 刘丹冰 | Add-第二章-项目构建 | 2019/9/18 |

| 刘丹冰 | Add-第三章-1-6节 Reactor | 2019/9/22 |

| 刘丹冰 | Add-第三章-7-16节 | 2019/10/15 |

| 刘丹冰 | Add-第四章-第五章 | 2019/10/30 |

| 刘丹冰 | Add-第六章-负载均衡模块 | 2019/11/29 |

| 刘丹冰 | Add-第七章-工具部分 | 2019/12/1 |

| 刘丹冰 | Add-第八章-优化建议 | 2019/12/5 |

[TOC]

系统开发环境:

Linux : Ubuntu18.04

protobuf : libprotoc 3.6.1版本及以上

mysql: mysql Ver 14.14 Distrib 5.7.27 版本及以上

g++: (Ubuntu 7.4.0-1ubuntu1~18.04.1) 7.4.0 版本及以上

一、概述:

Lars是一个简单、易用、高性能的服务间远程调用管理、调度、负载均衡系统。

1) 优势

性能强悍

集群支持千万并发链接,满足用户的海量业务访问需求。

高可用

采用集群化部署,支持多可用区的容灾,无缝实时切换。

灵活扩展

自动分发,与弹性伸缩无缝集成,灵活扩展用户用于的对外服务能力。

简单易用

快速部署、实时生效,支持多种协议,多种调度算法,用户可以高效的管理和调整服务分发策略等。

2) 应用场景

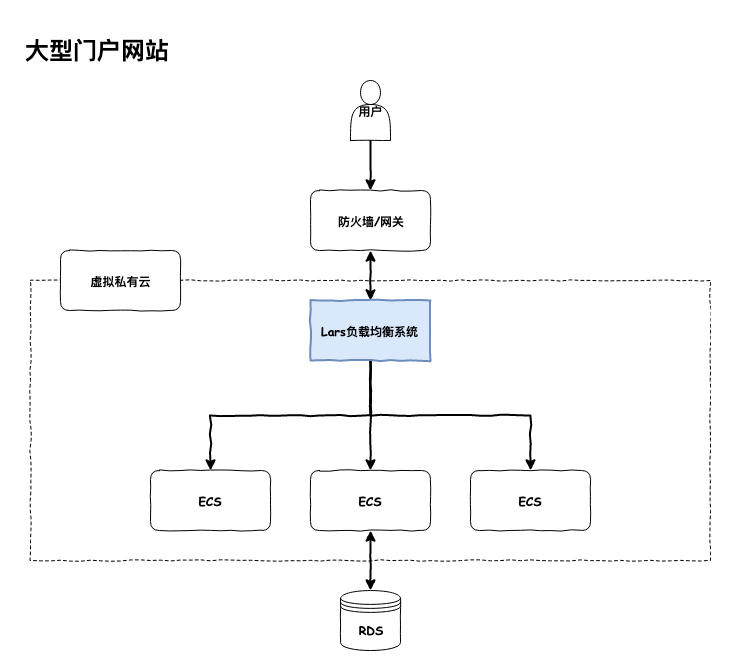

(1)、大型门户网站

针对大型门户网站访问量高的特点,通过弹性负载均衡将用户的访问流量均匀的分发到多个后端云服务器上,确保业务快速平稳的运行

优势

灵活扩展

可根据实际的用户访问量,自动扩展负载分发能力

高性能

集群支持高并发连接,满足海量访问量诉求

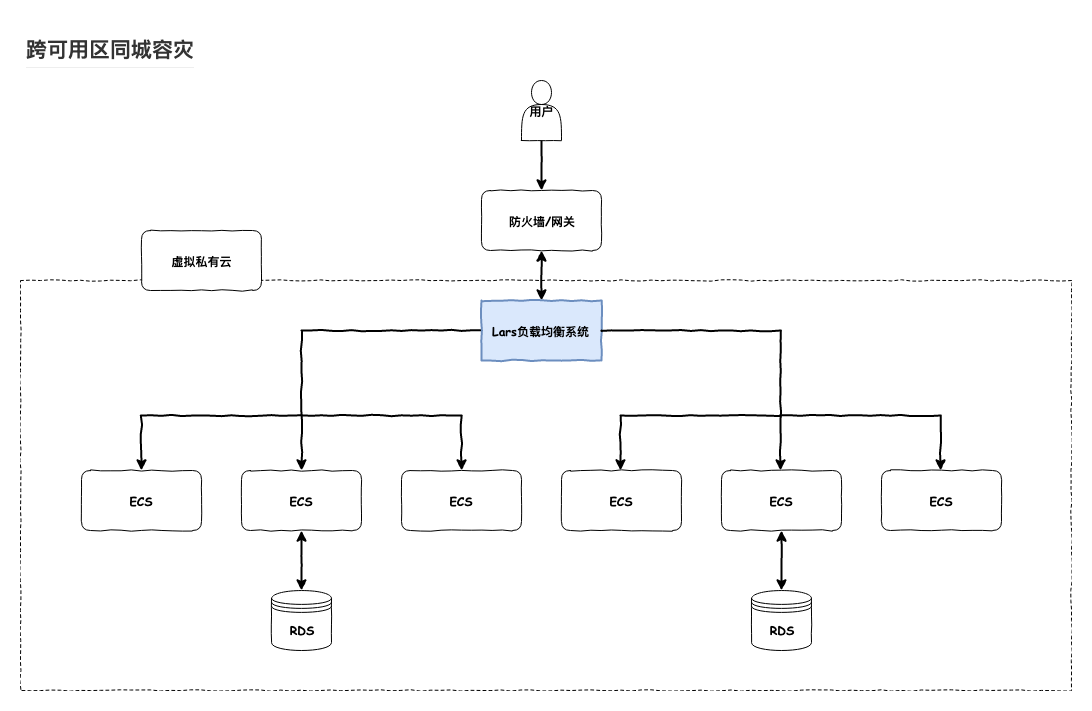

(2)、跨可用区同城容灾

弹性负载均衡可将流量跨可用区进行分发,建立实时的同城容灾机制,满足银行贸易等企业对系统的高可用性要求。

优势

灵活扩展

可根据实际的用户访问量,自动扩展负载分发能力

同城容灾

支持跨可用区的双活容灾,实现无缝实时切换

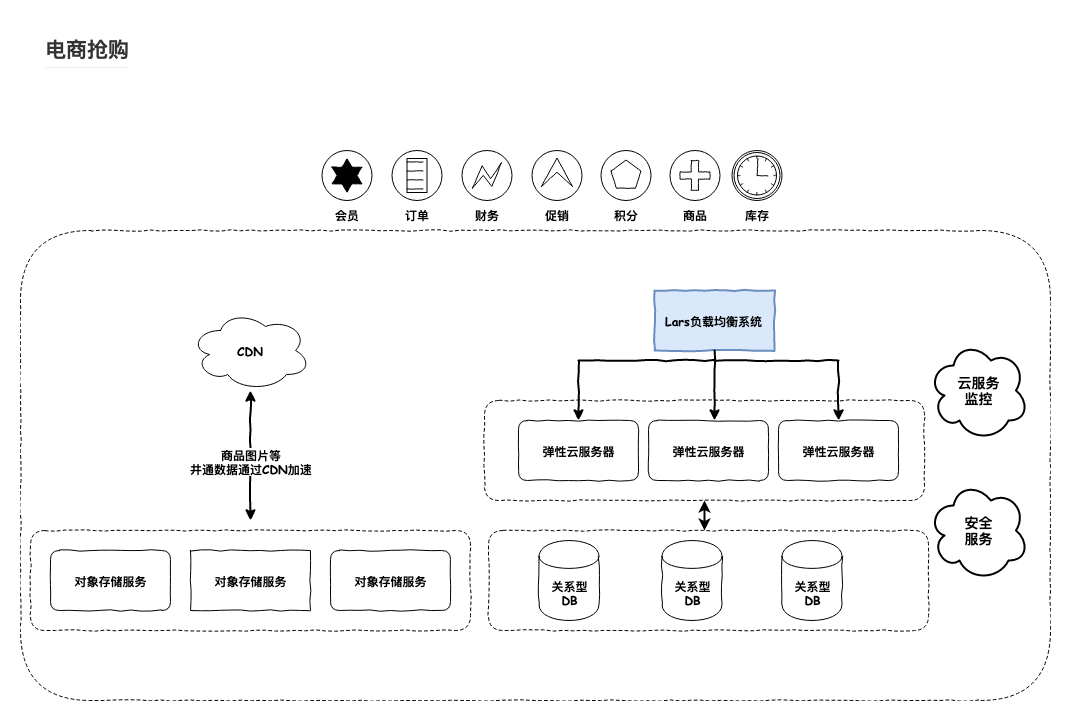

(3)、电商抢购

电商业务呈现出较强的潮汐效应。Lars通过和弹性伸缩等服务的无缝集成,自动创建后端云服务器,将流量自动分发到新的云服务器,缓解了促销高峰时期的系统压力。

优势

弹性伸缩

根据业务流量实时创建或移除云服务器

高可用

通过健康检查快速屏蔽异常云服务器,确保业务高可用

高性能

集群支持高并发连接,满足海量访问量诉求

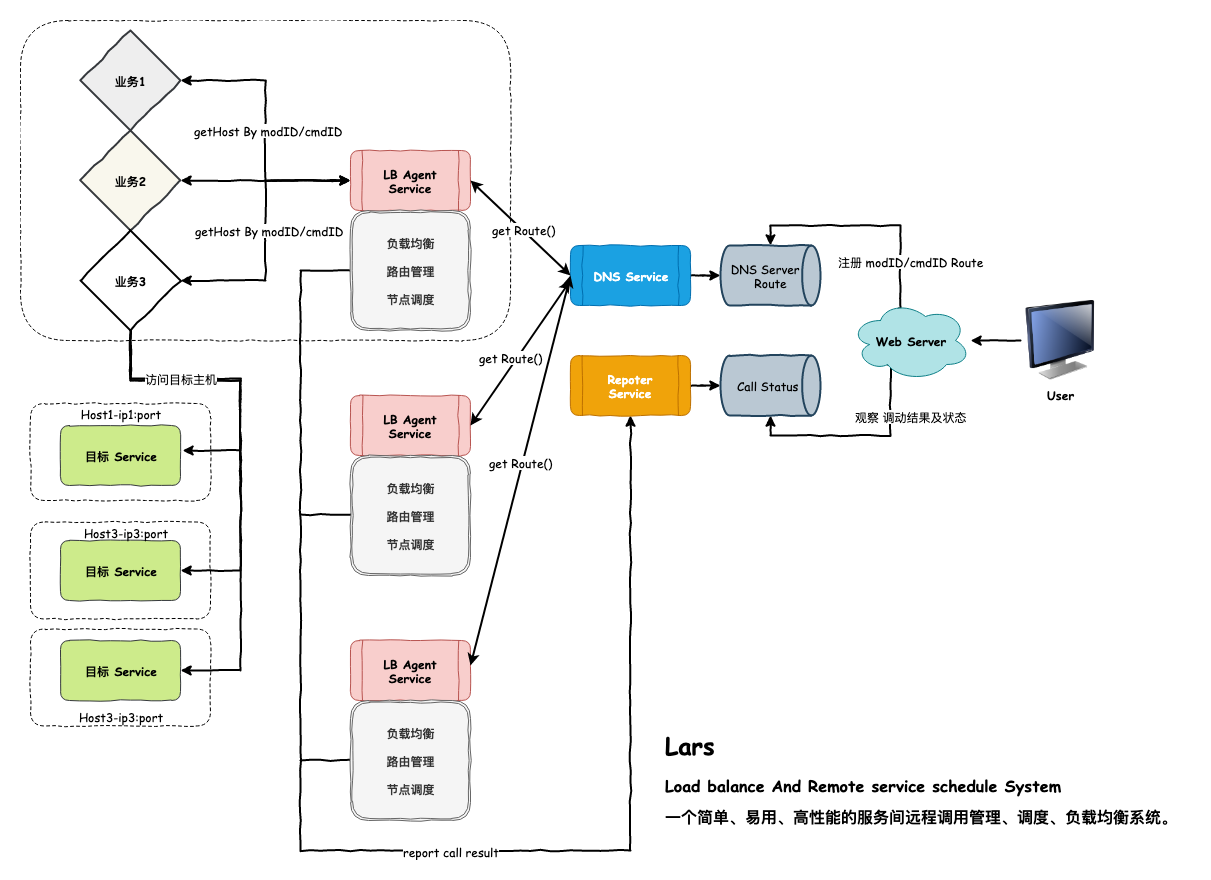

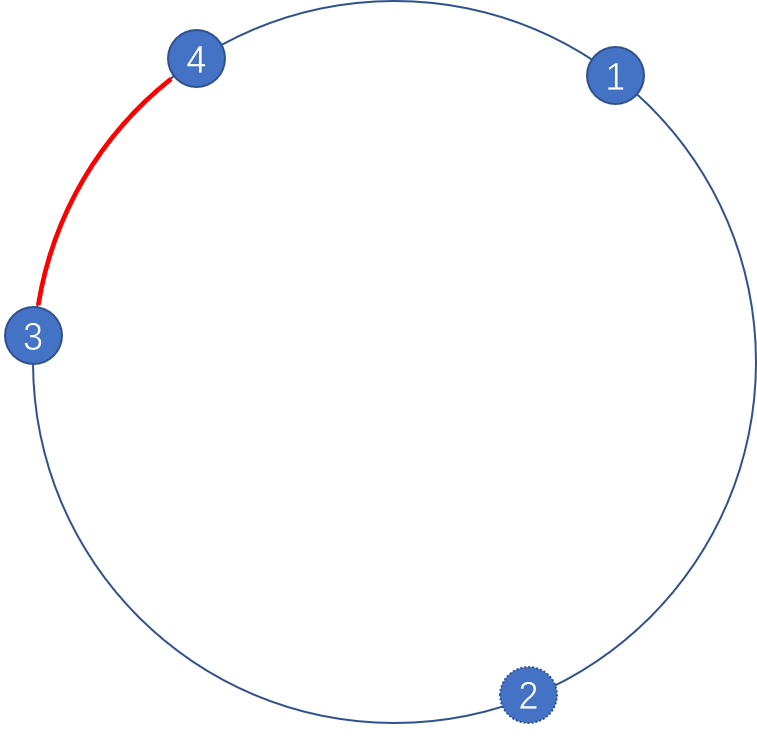

3) Lars系统总体架构

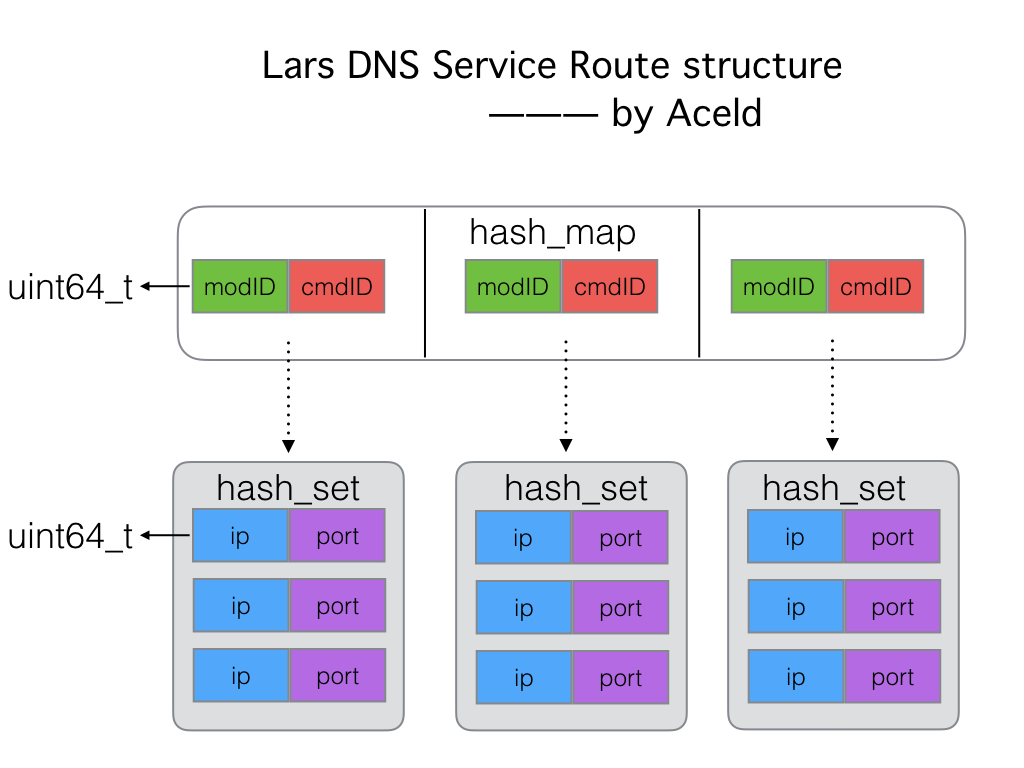

对于一个部门的后台,为增强灵活性,一个服务可以被抽象为命令字:modid+cmdid的组合,称为一个模块,而这个服务往往有多个服务节点,其所有服务节点的地址集合被称为这个模块下的路由,节点地址简称为节点

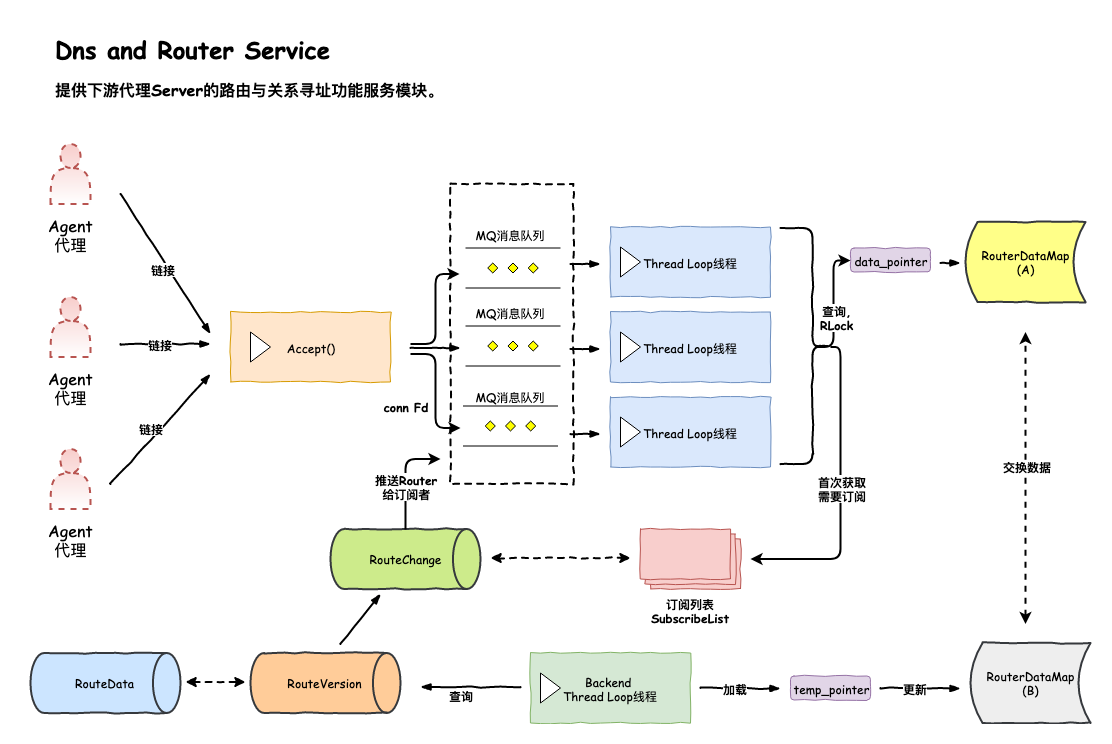

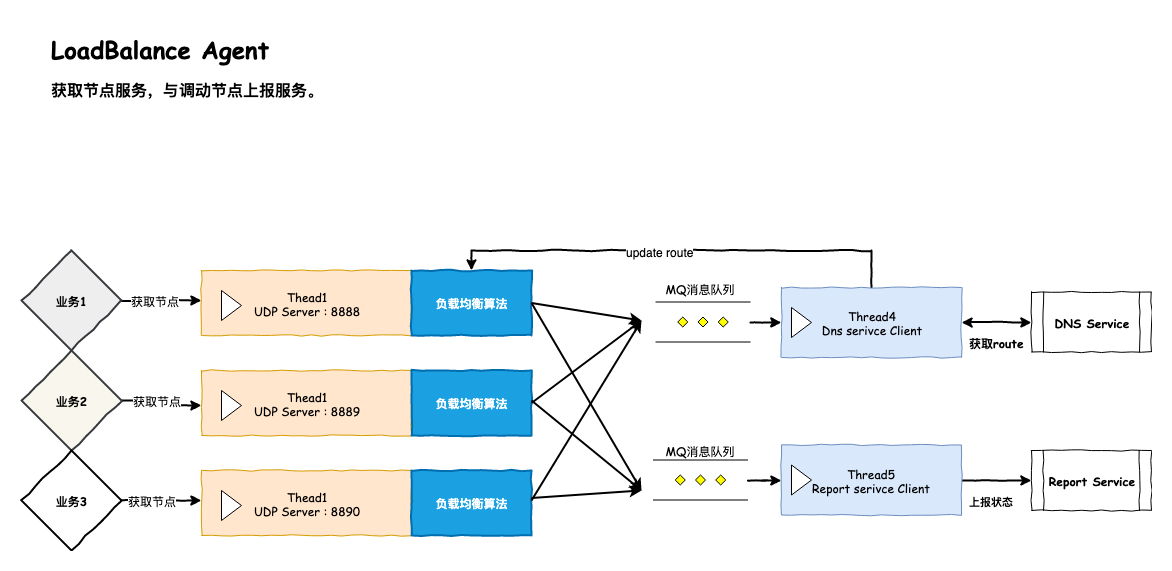

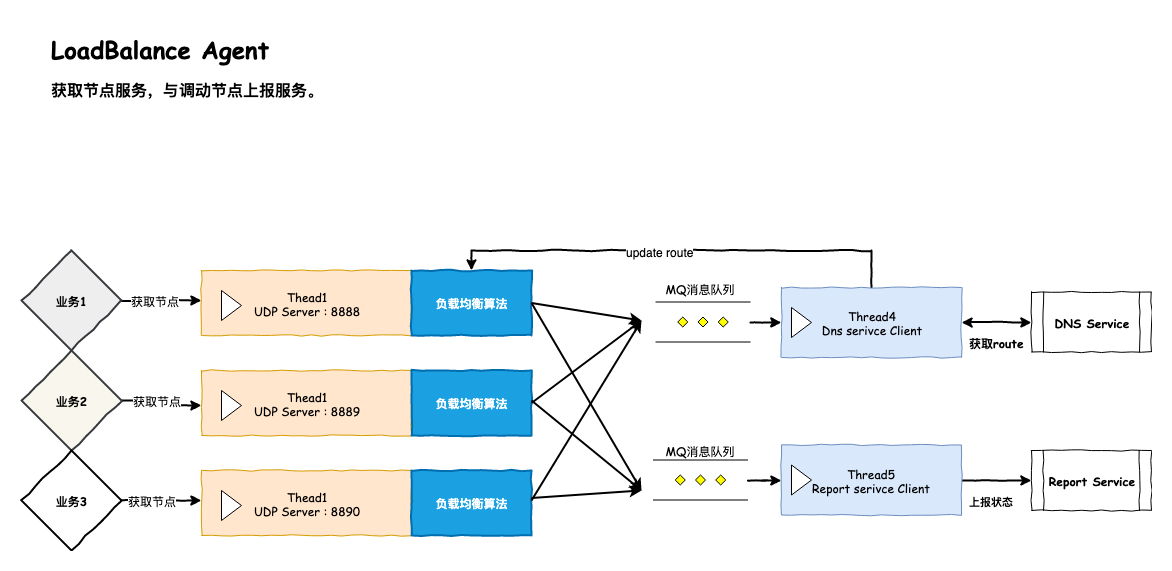

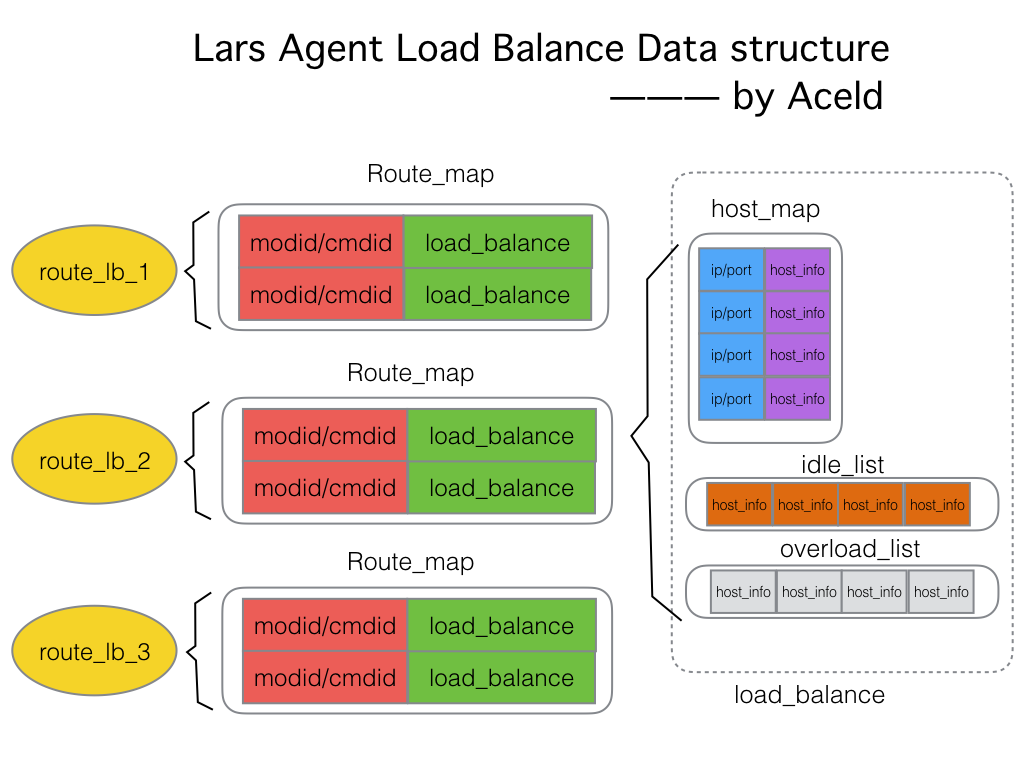

modid:标识业务的大类,如:“直播列表相关”cmdid:标识具体服务内容,如:“批量获取直播列表” 业务代码利用modid,cmdid,就可以调用对应的远程服务一个Lars系统包含一个DNSService,一个Report Service,以及部署于每个服务器的LoadBalance Agent,业务代码通过API与ELB系统进行交互

API :根据自身需要的modid,cmdid,向ELB系统获取节点、汇报节点调用结果;提供C++、Java、Python接口

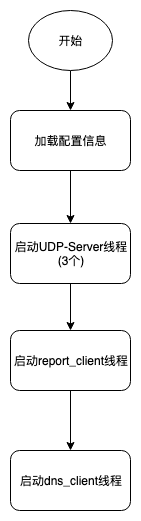

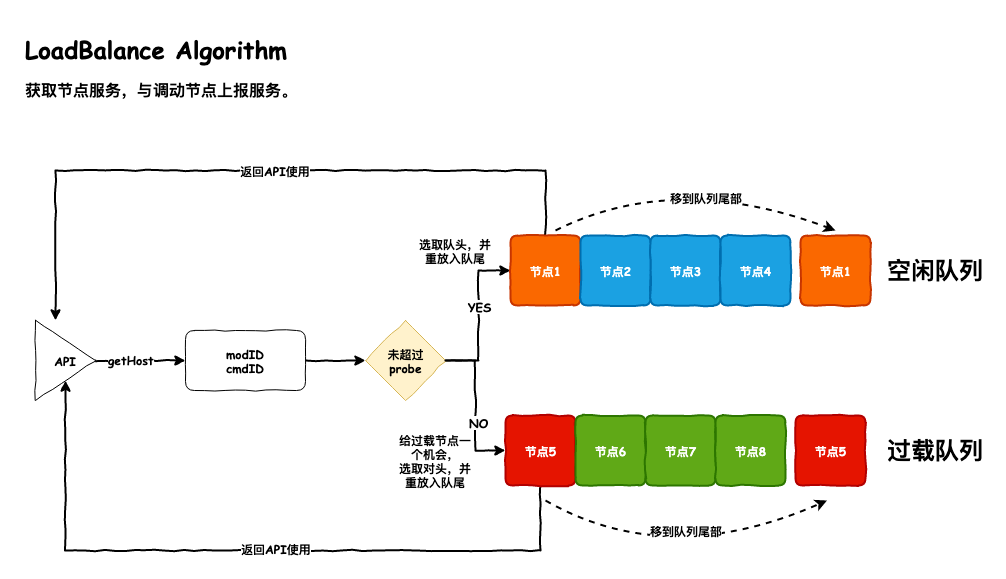

LoadBalance Agent:运行于每个服务器上,负责为此服务器上的业务提供节点获取、节点状态汇报、路由管理、负载调度等核心功能

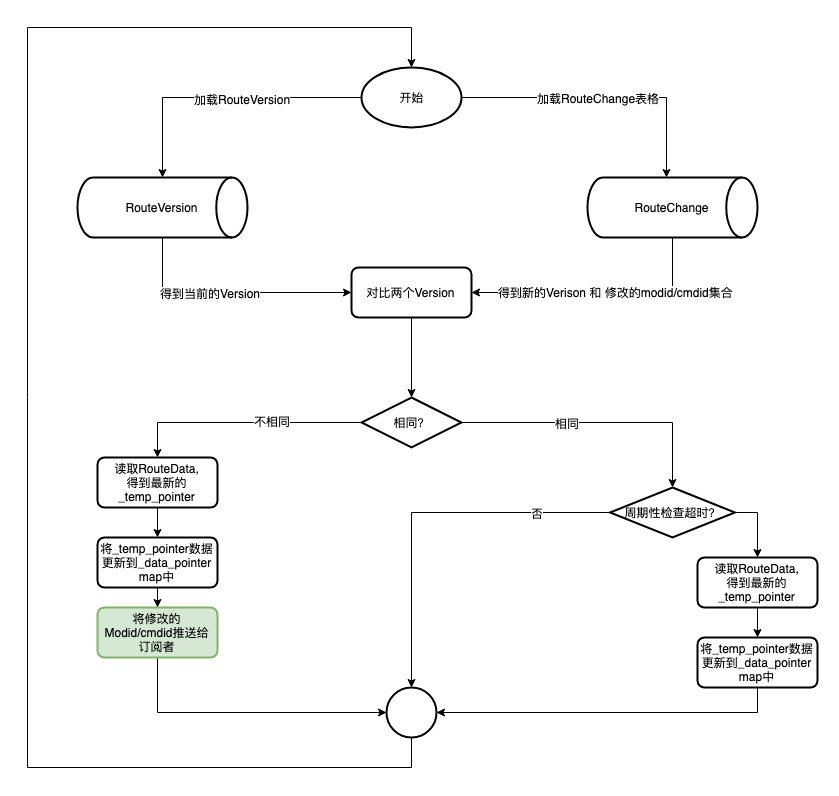

DNSService : 运行于一台服务器上(也可以用LVS部署多实例防单点),负责modid,cmdid到节点路由的转换

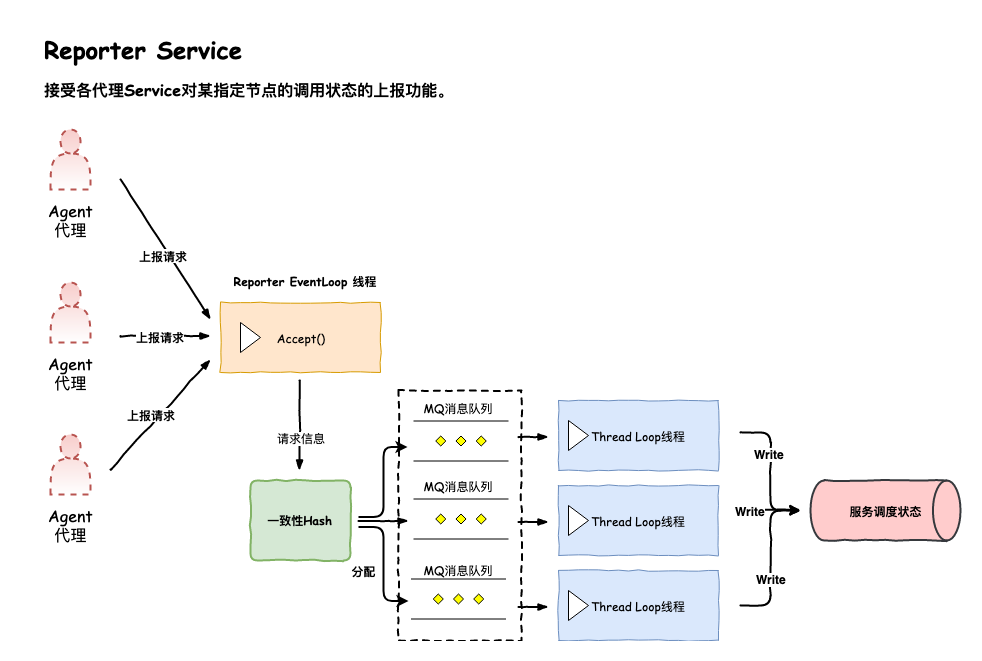

Report Service : 运行于DNSService同机服务器上,负责收集各modid,cmdid下各节点调用状况,可用于观察、报警

modid,cmdid数据由Mysql管理,具体SQL脚本在common/sql路径下

至于modid,cmdid的注册、删除可以利用Web端操作MySQL。

如图,每个服务器(虚线)部署了一台LoadBalance Agent,以及多个业务服务

- 开发者在Web端注册、删除、修改

modid,cmdid的路由信息,信息被写入到MySQL数据库; - 服务器上每个业务biz都把持着自己需要通信的远程服务标识

modid+cmdid,每个biz都向本机LoadBalance Agent获取远程节点,进而可以和远程目标服务通信,此外业务模块会汇报本次的节点调用结果给LoadBalance Agent; - LoadBalance Agent负责路由管理、负载均衡等核心任务,并周期性向DNSService获取最新的路由信息,周期性把各

modid,cmdid的各节点一段时间内的调用结果传给Report Service - DNSService监控MySQL,周期性将最新路由信息加载出来;

- Report Service将各

modid,cmdid的各节点一段时间内的调用结果写回到MySQL,方便Web端查看、报警

二、项目目录构建

首先在一切开始之前,我们应该将最基本的项目架构创建出来。

1)创建Lars代码总目录

$cd ~/

$mkdir Lars

2) 创建一个模块Lars_reactor

lars_reactor是一个网络IO库,是我们要实现的,我们就先以它作为第一个子项目进行构建。

$mkdir lars_reactor

然后在lars_reactor模块下创建一系列文件,如下

.

├── example

│ └── testlib

│ ├── hello_lars.cpp

│ └── Makefile

├── include

│ └── tcp_server.h

├── lib

├── Makefile

└── src

└── tcp_server.cpp

3)代码编写

src/tcp_server.cpp

#include <iostream>

void lars_hello()

{

std::cout <<"lars hello" <<std::endl;

}

src/tcp_server.h

#pragma once

void lars_hello();

我们要生成一个lib库文件liblreactor.a,来提供一些reactor模块的API接口。

生成liblreactor.a的Makefile如下

lars_reactor/Makefile

TARGET=lib/liblreactor.a

CXX=g++

CFLAGS=-g -O2 -Wall -fPIC -Wno-deprecated

SRC=./src

INC=-I./include

OBJS = $(addsuffix .o, $(basename $(wildcard $(SRC)/*.cpp)))

$(TARGET): $(OBJS)

mkdir -p lib

ar cqs $@ $^

%.o: %.cpp

$(CXX) $(CFLAGS) -c -o $@ $< $(INC)

.PHONY: clean

clean:

-rm -f src/*.o $(TARGET)

4)编译

$cd lars/lars_reactor/

$make

$g++ -g -O2 -Wall -fPIC -Wno-deprecated -c -o src/tcp_server.o src/tcp_server.cpp -I./include

mkdir -p lib

ar cqs lib/liblreactor.a src/tcp_server.o

我们会在lib下得到一个liblreactor.a库文件。

5)调用liblreactor.a接口

$cd lars/lars_reactor/

$mkdir example/testlib -p

$cd example/testlib/

hello_lars.cpp

#include "tcp_server.h"

int main() {

lars_hello();

return 0;

}

Makefile

CXX=g++

CFLAGS=-g -O2 -Wall -fPIC -Wno-deprecated

INC=-I../../include

LIB=-L../../lib -llreactor

OBJS = $(addsuffix .o, $(basename $(wildcard *.cc)))

all:

$(CXX) -o hello_lars $(CFLAGS) hello_lars.cpp $(INC) $(LIB)

clean:

-rm -f *.o hello_lars

编译

$ make

g++ -o hello_lars -g -O2 -Wall -fPIC -Wno-deprecated hello_lars.cpp -I../../include -L../../lib -llreactor

执行

$ ./hello_lars

lars hello

我们现在一个基本的项目目录就构建好了,大致如下

Lars/

├── lars_reactor

│ ├── example

│ │ └── testlib

│ │ ├── hello_lars

│ │ ├── hello_lars.cpp

│ │ └── Makefile

│ ├── include

│ │ └── tcp_server.h

│ ├── lib

│ │ └── liblreactor.a

│ ├── Makefile

│ └── src

│ ├── tcp_server.cpp

│ └── tcp_server.o

└── README.md

三、Lars-Reactor服务框架开发

1) 框架结构

2) Lars Reactor V0.1开发

我们首先先完成一个最基本的服务器开发模型,封装一个tcp_server类。

lars_reactor/include/tcp_server.h

#pragma once

#include <netinet/in.h>

class tcp_server

{

public:

//server的构造函数

tcp_server(const char *ip, uint16_t port);

//开始提供创建链接服务

void do_accept();

//链接对象释放的析构

~tcp_server();

private:

int _sockfd; //套接字

struct sockaddr_in _connaddr; //客户端链接地址

socklen_t _addrlen; //客户端链接地址长度

};

在tcp_server.cpp中完成基本的功能实现,我们在构造函数里将基本的socket创建服务器编程写完,然后提供一个阻塞的do_accept()方法。

lars_reactor/src/tcp_server.cpp

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <strings.h>

#include <unistd.h>

#include <signal.h>

#include <sys/types.h> /* See NOTES */

#include <sys/socket.h>

#include <arpa/inet.h>

#include <errno.h>

#include "tcp_server.h"

//server的构造函数

tcp_server::tcp_server(const char *ip, uint16_t port)

{

bzero(&_connaddr, sizeof(_connaddr));

//忽略一些信号 SIGHUP, SIGPIPE

//SIGPIPE:如果客户端关闭,服务端再次write就会产生

//SIGHUP:如果terminal关闭,会给当前进程发送该信号

if (signal(SIGHUP, SIG_IGN) == SIG_ERR) {

fprintf(stderr, "signal ignore SIGHUP\n");

}

if (signal(SIGPIPE, SIG_IGN) == SIG_ERR) {

fprintf(stderr, "signal ignore SIGPIPE\n");

}

//1. 创建socket

_sockfd = socket(AF_INET, SOCK_STREAM /*| SOCK_NONBLOCK*/ | SOCK_CLOEXEC, IPPROTO_TCP);

if (_sockfd == -1) {

fprintf(stderr, "tcp_server::socket()\n");

exit(1);

}

//2 初始化地址

struct sockaddr_in server_addr;

bzero(&server_addr, sizeof(server_addr));

server_addr.sin_family = AF_INET;

inet_aton(ip, &server_addr.sin_addr);

server_addr.sin_port = htons(port);

//2-1可以多次监听,设置REUSE属性

int op = 1;

if (setsockopt(_sockfd, SOL_SOCKET, SO_REUSEADDR, &op, sizeof(op)) < 0) {

fprintf(stderr, "setsocketopt SO_REUSEADDR\n");

}

//3 绑定端口

if (bind(_sockfd, (const struct sockaddr*)&server_addr, sizeof(server_addr)) < 0) {

fprintf(stderr, "bind error\n");

exit(1);

}

//4 监听ip端口

if (listen(_sockfd, 500) == -1) {

fprintf(stderr, "listen error\n");

exit(1);

}

}

//开始提供创建链接服务

void tcp_server::do_accept()

{

int connfd;

while(true) {

//accept与客户端创建链接

printf("begin accept\n");

connfd = accept(_sockfd, (struct sockaddr*)&_connaddr, &_addrlen);

if (connfd == -1) {

if (errno == EINTR) {

fprintf(stderr, "accept errno=EINTR\n");

continue;

}

else if (errno == EMFILE) {

//建立链接过多,资源不够

fprintf(stderr, "accept errno=EMFILE\n");

}

else if (errno == EAGAIN) {

fprintf(stderr, "accept errno=EAGAIN\n");

break;

}

else {

fprintf(stderr, "accept error");

exit(1);

}

}

else {

//accept succ!

//TODO 添加心跳机制

//TODO 消息队列机制

int writed;

char *data = "hello Lars\n";

do {

writed = write(connfd, data, strlen(data)+1);

} while (writed == -1 && errno == EINTR);

if (writed > 0) {

//succ

printf("write succ!\n");

}

if (writed == -1 && errno == EAGAIN) {

writed = 0; //不是错误,仅返回0表示此时不可继续写

}

}

}

}

//链接对象释放的析构

tcp_server::~tcp_server()

{

close(_sockfd);

}

好了,现在回到lars_reactor目录下进行编译。

$~/Lars/lars_reactor/

$make

在lib下,得到了库文件。

接下来,做一下测试,写一个简单的服务器应用.

$cd ~/Lars/lars_reactor/example

$mkdir lars_reactor_0.1

$cd lars_reactor_0.1

lars_reactor/example/lars_reactor_0.1/Makefile

CXX=g++

CFLAGS=-g -O2 -Wall -fPIC -Wno-deprecated

INC=-I../../include

LIB=-L../../lib -llreactor

OBJS = $(addsuffix .o, $(basename $(wildcard *.cc)))

all:

$(CXX) -o lars_reactor $(CFLAGS) lars_reactor.cpp $(INC) $(LIB)

clean:

-rm -f *.o lars_reactor

lars_reactor/example/lars_reactor_0.1/lars_reactor.cpp

#include "tcp_server.h"

int main() {

tcp_server server("127.0.0.1", 7777);

server.do_accept();

return 0;

}

接下来,我们make进行编译,编译的时候会指定链接我们刚才生成的liblreactor.a库。

服务端:

$ ./lars_reactor

begin accept

客户端:

$nc 127.0.0.1 7777

hello Lars

得到了服务器返回的结果,那么我们最开始的0.1版本就已经搭建完了,但是实际上这并不是一个并发服务器,万里长征才刚刚开始而已。

3) 内存管理与buffer封装

在完成网络框架之前,我们先把必须的内存管理和buffer的封装完成。

这里我们先创建一个io_buf类,主要用来封装基本的buffer结构。然后用一个buf_pool来管理全部的buffer集合。

3.1 io_buf 内存块

lars_reactor/include/io_buf.h

#pragma once

/*

定义一个 buffer存放数据的结构

* */

class io_buf {

public:

//构造,创建一个io_buf对象

io_buf(int size);

//清空数据

void clear();

//将已经处理过的数据,清空,将未处理的数据提前至数据首地址

void adjust();

//将其他io_buf对象数据考本到自己中

void copy(const io_buf *other);

//处理长度为len的数据,移动head和修正length

void pop(int len);

//如果存在多个buffer,是采用链表的形式链接起来

io_buf *next;

//当前buffer的缓存容量大小

int capacity;

//当前buffer有效数据长度

int length;

//未处理数据的头部位置索引

int head;

//当前io_buf所保存的数据地址

char *data;

};

对应的io_buf实现的文件,如下

lars_reactor/src/io_buf.cpp

#include <stdio.h>

#include <assert.h>

#include <string.h>

#include "io_buf.h"

//构造,创建一个io_buf对象

io_buf::io_buf(int size):

capacity(size),

length(0),

head(0),

next(NULL)

{

data = new char[size];

assert(data);

}

//清空数据

void io_buf::clear() {

length = head = 0;

}

//将已经处理过的数据,清空,将未处理的数据提前至数据首地址

void io_buf::adjust() {

if (head != 0) {

if (length != 0) {

memmove(data, data+head, length);

}

head = 0;

}

}

//将其他io_buf对象数据考本到自己中

void io_buf::copy(const io_buf *other) {

memcpy(data, other->data + other->head, other->length);

head = 0;

length = other->length;

}

//处理长度为len的数据,移动head和修正length

void io_buf::pop(int len) {

length -= len;

head += len;

}

这里主要要注意io_buf的两个索引值length和head,一个是当前buffer的有效内存长度,haed则为可用的有效长度首数据位置。 capacity是io_buf的总容量空间大小。

所以每次pop()则是弹出已经处理了多少,那么buffer剩下的内存就接下来需要处理的。

然而adjust()则是从新重置io_buf,将所有数据都重新变成未处理状态。

clear()则是将length和head清0,这里没有提供delete真是删除物理内存的方法,因为这里的buffer设计是不需要清理的,接下来是用一个buf_pool来管理全部未被使用的io_buf集合。而且buf_pool的管理的内存是程序开始预开辟的,不会做清理工作.

3.2 buf_pool 内存池

接下来我们看看内存池的设计.

lars_reactor/include/buf_pool.h

#pragma once

#include <ext/hash_map>

#include "io_buf.h"

typedef __gnu_cxx::hash_map<int, io_buf*> pool_t;

enum MEM_CAP {

m4K = 4096,

m16K = 16384,

m64K = 65536,

m256K = 262144,

m1M = 1048576,

m4M = 4194304,

m8M = 8388608

};

//总内存池最大限制 单位是Kb 所以目前限制是 5GB

#define EXTRA_MEM_LIMIT (5U *1024 *1024)

/*

* 定义buf内存池

* 设计为单例

* */

class buf_pool

{

public:

//初始化单例对象

static void init() {

//创建单例

_instance = new buf_pool();

}

//获取单例方法

static buf_pool *instance() {

//保证init方法在这个进程执行中 只被执行一次

pthread_once(&_once, init);

return _instance;

}

//开辟一个io_buf

io_buf *alloc_buf(int N);

io_buf *alloc_buf() { return alloc_buf(m4K); }

//重置一个io_buf

void revert(io_buf *buffer);

private:

buf_pool();

//拷贝构造私有化

buf_pool(const buf_pool&);

const buf_pool& operator=(const buf_pool&);

//所有buffer的一个map集合句柄

pool_t _pool;

//总buffer池的内存大小 单位为KB

uint64_t _total_mem;

//单例对象

static buf_pool *_instance;

//用于保证创建单例的init方法只执行一次的锁

static pthread_once_t _once;

//用户保护内存池链表修改的互斥锁

static pthread_mutex_t _mutex;

};

首先buf_pool采用单例的方式进行设计。因为系统希望仅有一个内存池管理模块。这里内存池用一个__gnu_cxx::hash_map<int, io_buf*>的map类型进行管理,其中key是每个组内存的空间容量,参考

enum MEM_CAP {

m4K = 4096,

m16K = 16384,

m64K = 65536,

m256K = 262144,

m1M = 1048576,

m4M = 4194304,

m8M = 8388608

};

其中每个key下面挂在一个io_buf链表。而且buf_pool预先会给map下的每个key的内存组开辟好一定数量的内存块。然后上层用户在使用的时候每次取出一个内存块,就会将该内存块从该内存组摘掉。当然使用完就放回来。如果不够使用会额外开辟,也有最大的内存限制,在宏EXTRA_MEM_LIMIT中。

具体的buf_pool实现如下:

lars_reactor/src/buf_pool.cpp

#include "buf_pool.h"

#include <assert.h>

//单例对象

buf_pool * buf_pool::_instance = NULL;

//用于保证创建单例的init方法只执行一次的锁

pthread_once_t buf_pool::_once = PTHREAD_ONCE_INIT;

//用户保护内存池链表修改的互斥锁

pthread_mutex_t buf_pool::_mutex = PTHREAD_MUTEX_INITIALIZER;

//构造函数 主要是预先开辟一定量的空间

//这里buf_pool是一个hash,每个key都是不同空间容量

//对应的value是一个io_buf集合的链表

//buf_pool --> [m4K] -- io_buf-io_buf-io_buf-io_buf...

// [m16K] -- io_buf-io_buf-io_buf-io_buf...

// [m64K] -- io_buf-io_buf-io_buf-io_buf...

// [m256K] -- io_buf-io_buf-io_buf-io_buf...

// [m1M] -- io_buf-io_buf-io_buf-io_buf...

// [m4M] -- io_buf-io_buf-io_buf-io_buf...

// [m8M] -- io_buf-io_buf-io_buf-io_buf...

buf_pool::buf_pool():_total_mem(0)

{

io_buf *prev;

//----> 开辟4K buf 内存池

_pool[m4K] = new io_buf(m4K);

if (_pool[m4K] == NULL) {

fprintf(stderr, "new io_buf m4K error");

exit(1);

}

prev = _pool[m4K];

//4K的io_buf 预先开辟5000个,约20MB供开发者使用

for (int i = 1; i < 5000; i ++) {

prev->next = new io_buf(m4K);

if (prev->next == NULL) {

fprintf(stderr, "new io_buf m4K error");

exit(1);

}

prev = prev->next;

}

_total_mem += 4 * 5000;

//----> 开辟16K buf 内存池

_pool[m16K] = new io_buf(m16K);

if (_pool[m16K] == NULL) {

fprintf(stderr, "new io_buf m16K error");

exit(1);

}

prev = _pool[m16K];

//16K的io_buf 预先开辟1000个,约16MB供开发者使用

for (int i = 1; i < 1000; i ++) {

prev->next = new io_buf(m16K);

if (prev->next == NULL) {

fprintf(stderr, "new io_buf m16K error");

exit(1);

}

prev = prev->next;

}

_total_mem += 16 * 1000;

//----> 开辟64K buf 内存池

_pool[m64K] = new io_buf(m64K);

if (_pool[m64K] == NULL) {

fprintf(stderr, "new io_buf m64K error");

exit(1);

}

prev = _pool[m64K];

//64K的io_buf 预先开辟500个,约32MB供开发者使用

for (int i = 1; i < 500; i ++) {

prev->next = new io_buf(m64K);

if (prev->next == NULL) {

fprintf(stderr, "new io_buf m64K error");

exit(1);

}

prev = prev->next;

}

_total_mem += 64 * 500;

//----> 开辟256K buf 内存池

_pool[m256K] = new io_buf(m256K);

if (_pool[m256K] == NULL) {

fprintf(stderr, "new io_buf m256K error");

exit(1);

}

prev = _pool[m256K];

//256K的io_buf 预先开辟200个,约50MB供开发者使用

for (int i = 1; i < 200; i ++) {

prev->next = new io_buf(m256K);

if (prev->next == NULL) {

fprintf(stderr, "new io_buf m256K error");

exit(1);

}

prev = prev->next;

}

_total_mem += 256 * 200;

//----> 开辟1M buf 内存池

_pool[m1M] = new io_buf(m1M);

if (_pool[m1M] == NULL) {

fprintf(stderr, "new io_buf m1M error");

exit(1);

}

prev = _pool[m1M];

//1M的io_buf 预先开辟50个,约50MB供开发者使用

for (int i = 1; i < 50; i ++) {

prev->next = new io_buf(m1M);

if (prev->next == NULL) {

fprintf(stderr, "new io_buf m1M error");

exit(1);

}

prev = prev->next;

}

_total_mem += 1024 * 50;

//----> 开辟4M buf 内存池

_pool[m4M] = new io_buf(m4M);

if (_pool[m4M] == NULL) {

fprintf(stderr, "new io_buf m4M error");

exit(1);

}

prev = _pool[m4M];

//4M的io_buf 预先开辟20个,约80MB供开发者使用

for (int i = 1; i < 20; i ++) {

prev->next = new io_buf(m4M);

if (prev->next == NULL) {

fprintf(stderr, "new io_buf m4M error");

exit(1);

}

prev = prev->next;

}

_total_mem += 4096 * 20;

//----> 开辟8M buf 内存池

_pool[m8M] = new io_buf(m8M);

if (_pool[m8M] == NULL) {

fprintf(stderr, "new io_buf m8M error");

exit(1);

}

prev = _pool[m8M];

//8M的io_buf 预先开辟10个,约80MB供开发者使用

for (int i = 1; i < 10; i ++) {

prev->next = new io_buf(m8M);

if (prev->next == NULL) {

fprintf(stderr, "new io_buf m8M error");

exit(1);

}

prev = prev->next;

}

_total_mem += 8192 * 10;

}

//开辟一个io_buf

//1 如果上层需要N个字节的大小的空间,找到与N最接近的buf hash组,取出,

//2 如果该组已经没有节点使用,可以额外申请

//3 总申请长度不能够超过最大的限制大小 EXTRA_MEM_LIMIT

//4 如果有该节点需要的内存块,直接取出,并且将该内存块从pool摘除

io_buf *buf_pool::alloc_buf(int N)

{

//1 找到N最接近哪hash 组

int index;

if (N <= m4K) {

index = m4K;

}

else if (N <= m16K) {

index = m16K;

}

else if (N <= m64K) {

index = m64K;

}

else if (N <= m256K) {

index = m256K;

}

else if (N <= m1M) {

index = m1M;

}

else if (N <= m4M) {

index = m4M;

}

else if (N <= m8M) {

index = m8M;

}

else {

return NULL;

}

//2 如果该组已经没有,需要额外申请,那么需要加锁保护

pthread_mutex_lock(&_mutex);

if (_pool[index] == NULL) {

if (_total_mem + index/1024 >= EXTRA_MEM_LIMIT) {

//当前的开辟的空间已经超过最大限制

fprintf(stderr, "already use too many memory!\n");

exit(1);

}

io_buf *new_buf = new io_buf(index);

if (new_buf == NULL) {

fprintf(stderr, "new io_buf error\n");

exit(1);

}

_total_mem += index/1024;

pthread_mutex_unlock(&_mutex);

return new_buf;

}

//3 从pool中摘除该内存块

io_buf *target = _pool[index];

_pool[index] = target->next;

pthread_mutex_unlock(&_mutex);

target->next = NULL;

return target;

}

//重置一个io_buf,将一个buf 上层不再使用,或者使用完成之后,需要将该buf放回pool中

void buf_pool::revert(io_buf *buffer)

{

//每个buf的容量都是固定的 在hash的key中取值

int index = buffer->capacity;

//重置io_buf中的内置位置指针

buffer->length = 0;

buffer->head = 0;

pthread_mutex_lock(&_mutex);

//找到对应的hash组 buf首届点地址

assert(_pool.find(index) != _pool.end());

//将buffer插回链表头部

buffer->next = _pool[index];

_pool[index] = buffer;

pthread_mutex_unlock(&_mutex);

}

其中,buf_pool构造函数中实现了内存池的hash预开辟内存工作,具体的数据结构如下

//buf_pool --> [m4K] --> io_buf-io_buf-io_buf-io_buf...

// [m16K] --> io_buf-io_buf-io_buf-io_buf...

// [m64K] --> io_buf-io_buf-io_buf-io_buf...

// [m256K] --> io_buf-io_buf-io_buf-io_buf...

// [m1M] --> io_buf-io_buf-io_buf-io_buf...

// [m4M] --> io_buf-io_buf-io_buf-io_buf...

// [m8M] --> io_buf-io_buf-io_buf-io_buf...

alloc_buf()方法,是调用者从内存池中取出一块内存,如果最匹配的内存块存在,则返回,并将该块内存从buf_pool中摘除掉,如果没有则开辟一个内存出来。 revert()方法则是将已经使用完的io_buf重新放回buf_pool中。

3.3 读写buffer机制

那么接下来我们就需要实现一个专门用来读(输入)数据的input_buf和专门用来写(输出)数据的output_buf类了。由于这两个人都应该拥有一些io_buf的特性,所以我们先定义一个基础的父类reactor_buf。

A. reactor_buf类

lars_reactor/include/reactor_buf.h

#pragma once

#include "io_buf.h"

#include "buf_pool.h"

#include <assert.h>

#include <unistd.h>

/*

* 给业务层提供的最后tcp_buffer结构

* */

class reactor_buf {

public:

reactor_buf();

~reactor_buf();

const int length() const;

void pop(int len);

void clear();

protected:

io_buf *_buf;

};

这个的作用就是将io_buf作为自己的一个成员,然后做了一些包装。具体方法实现如下。

lars_reactor/src/reactor.cpp

#include "reactor_buf.h"

#include <sys/ioctl.h>

#include <string.h>

reactor_buf::reactor_buf()

{

_buf = NULL;

}

reactor_buf::~reactor_buf()

{

clear();

}

const int reactor_buf::length() const

{

return _buf != NULL? _buf->length : 0;

}

void reactor_buf::pop(int len)

{

assert(_buf != NULL && len <= _buf->length);

_buf->pop(len);

//当此时_buf的可用长度已经为0

if(_buf->length == 0) {

//将_buf重新放回buf_pool中

buf_pool::instance()->revert(_buf);

_buf = NULL;

}

}

void reactor_buf::clear()

{

if (_buf != NULL) {

//将_buf重新放回buf_pool中

buf_pool::instance()->revert(_buf);

_buf = NULL;

}

}

B. input_buf类

接下来就可以集成reactor_buf类实现input_buf类的设计了。

lars_reactor/include/reactor_buf.h

//读(输入) 缓存buffer

class input_buf : public reactor_buf

{

public:

//从一个fd中读取数据到reactor_buf中

int read_data(int fd);

//取出读到的数据

const char *data() const;

//重置缓冲区

void adjust();

};

其中data()方法即取出已经读取的数据,adjust()含义和io_buf含义一致。主要是read_data()方法。具体实现如下。

lars_reactor/src/reactor.cpp

//从一个fd中读取数据到reactor_buf中

int input_buf::read_data(int fd)

{

int need_read;//硬件有多少数据可以读

//一次性读出所有的数据

//需要给fd设置FIONREAD,

//得到read缓冲中有多少数据是可以读取的

if (ioctl(fd, FIONREAD, &need_read) == -1) {

fprintf(stderr, "ioctl FIONREAD\n");

return -1;

}

if (_buf == NULL) {

//如果io_buf为空,从内存池申请

_buf = buf_pool::instance()->alloc_buf(need_read);

if (_buf == NULL) {

fprintf(stderr, "no idle buf for alloc\n");

return -1;

}

}

else {

//如果io_buf可用,判断是否够存

assert(_buf->head == 0);

if (_buf->capacity - _buf->length < (int)need_read) {

//不够存,冲内存池申请

io_buf *new_buf = buf_pool::instance()->alloc_buf(need_read+_buf->length);

if (new_buf == NULL) {

fprintf(stderr, "no ilde buf for alloc\n");

return -1;

}

//将之前的_buf的数据考到新申请的buf中

new_buf->copy(_buf);

//将之前的_buf放回内存池中

buf_pool::instance()->revert(_buf);

//新申请的buf成为当前io_buf

_buf = new_buf;

}

}

//读取数据

int already_read = 0;

do {

//读取的数据拼接到之前的数据之后

if(need_read == 0) {

//可能是read阻塞读数据的模式,对方未写数据

already_read = read(fd, _buf->data + _buf->length, m4K);

} else {

already_read = read(fd, _buf->data + _buf->length, need_read);

}

} while (already_read == -1 && errno == EINTR); //systemCall引起的中断 继续读取

if (already_read > 0) {

if (need_read != 0) {

assert(already_read == need_read);

}

_buf->length += already_read;

}

return already_read;

}

//取出读到的数据

const char *input_buf::data() const

{

return _buf != NULL ? _buf->data + _buf->head : NULL;

}

//重置缓冲区

void input_buf::adjust()

{

if (_buf != NULL) {

_buf->adjust();

}

}

C. output_buf类

接下来就可以集成reactor_buf类实现output_buf类的设计了。

lars_reactor/include/reactor_buf.h

//写(输出) 缓存buffer

class output_buf : public reactor_buf

{

public:

//将一段数据 写到一个reactor_buf中

int send_data(const char *data, int datalen);

//将reactor_buf中的数据写到一个fd中

int write2fd(int fd);

};

send_data()方法主要是将数据写到io_buf中,实际上并没有做真正的写操作。而是当调用write2fd方法时,才会将io_buf的数据写到对应的fd中。send_data是做一些buf内存块的申请等工作。具体实现如下

lars_reactor/src/reactor.cpp

//将一段数据 写到一个reactor_buf中

int output_buf::send_data(const char *data, int datalen)

{

if (_buf == NULL) {

//如果io_buf为空,从内存池申请

_buf = buf_pool::instance()->alloc_buf(datalen);

if (_buf == NULL) {

fprintf(stderr, "no idle buf for alloc\n");

return -1;

}

}

else {

//如果io_buf可用,判断是否够存

assert(_buf->head == 0);

if (_buf->capacity - _buf->length < datalen) {

//不够存,冲内存池申请

io_buf *new_buf = buf_pool::instance()->alloc_buf(datalen+_buf->length);

if (new_buf == NULL) {

fprintf(stderr, "no ilde buf for alloc\n");

return -1;

}

//将之前的_buf的数据考到新申请的buf中

new_buf->copy(_buf);

//将之前的_buf放回内存池中

buf_pool::instance()->revert(_buf);

//新申请的buf成为当前io_buf

_buf = new_buf;

}

}

//将data数据拷贝到io_buf中,拼接到后面

memcpy(_buf->data + _buf->length, data, datalen);

_buf->length += datalen;

return 0;

}

//将reactor_buf中的数据写到一个fd中

int output_buf::write2fd(int fd)

{

assert(_buf != NULL && _buf->head == 0);

int already_write = 0;

do {

already_write = write(fd, _buf->data, _buf->length);

} while (already_write == -1 && errno == EINTR); //systemCall引起的中断,继续写

if (already_write > 0) {

//已经处理的数据清空

_buf->pop(already_write);

//未处理数据前置,覆盖老数据

_buf->adjust();

}

//如果fd非阻塞,可能会得到EAGAIN错误

if (already_write == -1 && errno == EAGAIN) {

already_write = 0;//不是错误,仅仅返回0,表示目前是不可以继续写的

}

return already_write;

}

现在我们已经完成了内存管理及读写buf机制的实现,接下来就要简单的测试一下,用我们之前的V0.1版本的reactor server来测试。

3.4 完成Lars Reactor V0.2开发

A. 修改tcp_server

主要修正do_accept()方法,加上reactor_buf机制.

lars_reactor/src/tcp_server.cpp

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <strings.h>

#include <unistd.h>

#include <signal.h>

#include <sys/types.h> /* See NOTES */

#include <sys/socket.h>

#include <arpa/inet.h>

#include <errno.h>

#include "tcp_server.h"

#include "reactor_buf.h"

//server的构造函数

tcp_server::tcp_server(const char *ip, uint16_t port)

{

//...

}

//开始提供创建链接服务

void tcp_server::do_accept()

{

int connfd;

while(true) {

//accept与客户端创建链接

printf("begin accept\n");

connfd = accept(_sockfd, (struct sockaddr*)&_connaddr, &_addrlen);

if (connfd == -1) {

if (errno == EINTR) {

fprintf(stderr, "accept errno=EINTR\n");

continue;

}

else if (errno == EMFILE) {

//建立链接过多,资源不够

fprintf(stderr, "accept errno=EMFILE\n");

}

else if (errno == EAGAIN) {

fprintf(stderr, "accept errno=EAGAIN\n");

break;

}

else {

fprintf(stderr, "accept error");

exit(1);

}

}

else {

//accept succ!

int ret = 0;

input_buf ibuf;

output_buf obuf;

char *msg = NULL;

int msg_len = 0;

do {

ret = ibuf.read_data(connfd);

if (ret == -1) {

fprintf(stderr, "ibuf read_data error\n");

break;

}

printf("ibuf.length() = %d\n", ibuf.length());

//将读到的数据放在msg中

msg_len = ibuf.length();

msg = (char*)malloc(msg_len);

bzero(msg, msg_len);

memcpy(msg, ibuf.data(), msg_len);

ibuf.pop(msg_len);

ibuf.adjust();

printf("recv data = %s\n", msg);

//回显数据

obuf.send_data(msg, msg_len);

while(obuf.length()) {

int write_ret = obuf.write2fd(connfd);

if (write_ret == -1) {

fprintf(stderr, "write connfd error\n");

return;

}

else if(write_ret == 0) {

//不是错误,表示此时不可写

break;

}

}

free(msg);

} while (ret != 0);

//Peer is closed

close(connfd);

}

}

}

编译生成新的liblreactor.a

$cd lars_reactor/

$make

g++ -g -O2 -Wall -fPIC -Wno-deprecated -c -o src/tcp_server.o src/tcp_server.cpp -I./include

g++ -g -O2 -Wall -fPIC -Wno-deprecated -c -o src/io_buf.o src/io_buf.cpp -I./include

g++ -g -O2 -Wall -fPIC -Wno-deprecated -c -o src/reactor_buf.o src/reactor_buf.cpp -I./include

g++ -g -O2 -Wall -fPIC -Wno-deprecated -c -o src/buf_pool.o src/buf_pool.cpp -I./include

mkdir -p lib

ar cqs lib/liblreactor.a src/tcp_server.o src/io_buf.o src/reactor_buf.o src/buf_pool.o

B. 编译V0.2 server APP

我们将lars_reactor/example/lars_reactor_0.1 的代码复制一份到 lars_reactor/example/lars_reactor_0.2中。

由于我们这里使用了pthread库,所以在lars_reactor_0.2的Makefile文件要加上pthread库的关联

lars_reactor/example/lars_reactor_0.2/Makefile

CXX=g++

CFLAGS=-g -O2 -Wall -fPIC -Wno-deprecated

INC=-I../../include

LIB=-L../../lib -llreactor -lpthread

OBJS = $(addsuffix .o, $(basename $(wildcard *.cc)))

all:

$(CXX) -o lars_reactor $(CFLAGS) lars_reactor.cpp $(INC) $(LIB)

clean:

-rm -f *.o lars_reactor

编译在lars_reactor/example/lars_reactor_0.2/

$ cd lars_reactor/example/lars_reactor_0.2/

$ make

g++ -o lars_reactor -g -O2 -Wall -fPIC -Wno-deprecated lars_reactor.cpp -I../../include -L../../lib -llreactor -lpthread

C. 测试

启动server

$ ./lars_reactor

begin accept

启动client

$ nc 127.0.0.1 7777

客户端输入 文字,效果如下:

服务端:

ibuf.length() = 21

recv data = hello lars, By Aceld

客户端:

$ nc 127.0.0.1 7777

hello lars, By Aceld

hello lars, By Aceld

ok!现在我们的读写buffer机制已经成功的集成到我们的lars网络框架中了。

4) 事件触发event_loop

接下来我们要尝试添加多路IO的处理机制,当然linux的平台下, 最优的选择就是使用epoll来做,但是用原生的epoll实际上编程起来扩展性不是很强,那么我们就需要封装一套IO事件处理机制。

4.1 io_event基于IO事件封装

我们首先定义一个IO事件类来包括一个时间需要拥有的基本成员信息.

lars_reactor/include/event_base.h

#pragma once

/*

* 定义一些IO复用机制或者其他异常触发机制的事件封装

*

* */

class event_loop;

//IO事件触发的回调函数

typedef void io_callback(event_loop *loop, int fd, void *args);

/*

* 封装一次IO触发实现

* */

struct io_event

{

io_event():read_callback(NULL),write_callback(NULL),rcb_args(NULL),wcb_args(NULL) {}

int mask; //EPOLLIN EPOLLOUT

io_callback *read_callback; //EPOLLIN事件 触发的回调

io_callback *write_callback;//EPOLLOUT事件 触发的回调

void *rcb_args; //read_callback的回调函数参数

void *wcb_args; //write_callback的回调函数参数

};

一个io_event对象应该包含 一个epoll的事件标识EPOLLIN/EPOLLOUT,和对应事件的处理函数read_callback,write_callback。他们都应该是io_callback类型。然后对应的函数形参。

4.2 event_loop事件循环处理机制

接下来我们就要通过event_loop类来实现io_event的基本增删操作,放在原生的epoll堆中。

lars_reactor/include/event_loop.h

#pragma once

/*

*

* event_loop事件处理机制

*

* */

#include <sys/epoll.h>

#include <ext/hash_map>

#include <ext/hash_set>

#include "event_base.h"

#define MAXEVENTS 10

// map: fd->io_event

typedef __gnu_cxx::hash_map<int, io_event> io_event_map;

//定义指向上面map类型的迭代器

typedef __gnu_cxx::hash_map<int, io_event>::iterator io_event_map_it;

//全部正在监听的fd集合

typedef __gnu_cxx::hash_set<int> listen_fd_set;

class event_loop

{

public:

//构造,初始化epoll堆

event_loop();

//阻塞循环处理事件

void event_process();

//添加一个io事件到loop中

void add_io_event(int fd, io_callback *proc, int mask, void *args=NULL);

//删除一个io事件从loop中

void del_io_event(int fd);

//删除一个io事件的EPOLLIN/EPOLLOUT

void del_io_event(int fd, int mask);

private:

int _epfd; //epoll fd

//当前event_loop 监控的fd和对应事件的关系

io_event_map _io_evs;

//当前event_loop 一共哪些fd在监听

listen_fd_set listen_fds;

//一次性最大处理的事件

struct epoll_event _fired_evs[MAXEVENTS];

};

属性:

_epfd:是epoll原生堆的fd。

_io_evs:是一个hash_map对象,主要是方便我们管理fd<—>io_event的对应关系,方便我们来查找和处理。

_listen_fds:记录目前一共有多少个fd正在本我们的event_loop机制所监控.

_fried_evs:已经通过epoll_wait返回的被激活需要上层处理的fd集合.

方法:

event_loop():构造函数,主要初始化epoll.

event_process():永久阻塞,等待触发的事件,去调用对应的函数callback方法。

add_io_event():绑定一个fd和一个io_event的关系,并添加对应的事件到event_loop中。

del_io_event():从event_loop删除该事件。

具体实现方法如下:

lars_reactor/src/event_loop.cpp

#include "event_loop.h"

#include <assert.h>

//构造,初始化epoll堆

event_loop::event_loop()

{

//flag=0 等价于epll_craete

_epfd = epoll_create1(0);

if (_epfd == -1) {

fprintf(stderr, "epoll_create error\n");

exit(1);

}

}

//阻塞循环处理事件

void event_loop::event_process()

{

while (true) {

io_event_map_it ev_it;

int nfds = epoll_wait(_epfd, _fired_evs, MAXEVENTS, 10);

for (int i = 0; i < nfds; i++) {

//通过触发的fd找到对应的绑定事件

ev_it = _io_evs.find(_fired_evs[i].data.fd);

assert(ev_it != _io_evs.end());

io_event *ev = &(ev_it->second);

if (_fired_evs[i].events & EPOLLIN) {

//读事件,掉读回调函数

void *args = ev->rcb_args;

ev->read_callback(this, _fired_evs[i].data.fd, args);

}

else if (_fired_evs[i].events & EPOLLOUT) {

//写事件,掉写回调函数

void *args = ev->wcb_args;

ev->write_callback(this, _fired_evs[i].data.fd, args);

}

else if (_fired_evs[i].events &(EPOLLHUP|EPOLLERR)) {

//水平触发未处理,可能会出现HUP事件,正常处理读写,没有则清空

if (ev->read_callback != NULL) {

void *args = ev->rcb_args;

ev->read_callback(this, _fired_evs[i].data.fd, args);

}

else if (ev->write_callback != NULL) {

void *args = ev->wcb_args;

ev->write_callback(this, _fired_evs[i].data.fd, args);

}

else {

//删除

fprintf(stderr, "fd %d get error, delete it from epoll\n", _fired_evs[i].data.fd);

this->del_io_event(_fired_evs[i].data.fd);

}

}

}

}

}

/*

* 这里我们处理的事件机制是

* 如果EPOLLIN 在mask中, EPOLLOUT就不允许在mask中

* 如果EPOLLOUT 在mask中, EPOLLIN就不允许在mask中

* 如果想注册EPOLLIN|EPOLLOUT的事件, 那么就调用add_io_event() 方法两次来注册。

* */

//添加一个io事件到loop中

void event_loop::add_io_event(int fd, io_callback *proc, int mask, void *args)

{

int final_mask;

int op;

//1 找到当前fd是否已经有事件

io_event_map_it it = _io_evs.find(fd);

if (it == _io_evs.end()) {

//2 如果没有操作动作就是ADD

//没有找到

final_mask = mask;

op = EPOLL_CTL_ADD;

}

else {

//3 如果有操作董酒是MOD

//添加事件标识位

final_mask = it->second.mask | mask;

op = EPOLL_CTL_MOD;

}

//4 注册回调函数

if (mask & EPOLLIN) {

//读事件回调函数注册

_io_evs[fd].read_callback = proc;

_io_evs[fd].rcb_args = args;

}

else if (mask & EPOLLOUT) {

_io_evs[fd].write_callback = proc;

_io_evs[fd].wcb_args = args;

}

//5 epoll_ctl添加到epoll堆里

_io_evs[fd].mask = final_mask;

//创建原生epoll事件

struct epoll_event event;

event.events = final_mask;

event.data.fd = fd;

if (epoll_ctl(_epfd, op, fd, &event) == -1) {

fprintf(stderr, "epoll ctl %d error\n", fd);

return;

}

//6 将fd添加到监听集合中

listen_fds.insert(fd);

}

//删除一个io事件从loop中

void event_loop::del_io_event(int fd)

{

//将事件从_io_evs删除

_io_evs.erase(fd);

//将fd从监听集合中删除

listen_fds.erase(fd);

//将fd从epoll堆删除

epoll_ctl(_epfd, EPOLL_CTL_DEL, fd, NULL);

}

//删除一个io事件的EPOLLIN/EPOLLOUT

void event_loop::del_io_event(int fd, int mask)

{

//如果没有该事件,直接返回

io_event_map_it it = _io_evs.find(fd);

if (it == _io_evs.end()) {

return ;

}

int &o_mask = it->second.mask;

//修正mask

o_mask = o_mask & (~mask);

if (o_mask == 0) {

//如果修正之后 mask为0,则删除

this->del_io_event(fd);

}

else {

//如果修正之后,mask非0,则修改

struct epoll_event event;

event.events = o_mask;

event.data.fd = fd;

epoll_ctl(_epfd, EPOLL_CTL_MOD, fd, &event);

}

}

这里del_io_event提供两个重载,一个是直接删除事件,一个是修正事件。

4.3 Reactor集成event_loop机制

好了,那么接下来,就让让Lars Reactor框架集成event_loop机制。

首先简单修正一个tcp_server.cpp文件,对之前的do_accept()的调度时机做一下修正。

1. 在`tcp_server`成员新增`event_loop`成员。

lars_reactor/include/tcp_server.h

#pragma once

#include <netinet/in.h>

#include "event_loop.h"

class tcp_server

{

public:

//server的构造函数

tcp_server(event_loop* loop, const char *ip, uint16_t port);

//开始提供创建链接服务

void do_accept();

//链接对象释放的析构

~tcp_server();

private:

int _sockfd; //套接字

struct sockaddr_in _connaddr; //客户端链接地址

socklen_t _addrlen; //客户端链接地址长度

// ============= 新增 ======================

//event_loop epoll事件机制

event_loop* _loop;

// ============= 新增 ======================

};

- 构造函数在创建完listen fd之后,添加accept事件。

lars_reactor/src/tcp_server.cpp

//listen fd 客户端有新链接请求过来的回调函数

void accept_callback(event_loop *loop, int fd, void *args)

{

tcp_server *server = (tcp_server*)args;

server->do_accept();

}

//server的构造函数

tcp_server::tcp_server(event_loop *loop, const char *ip, uint16_t port)

{

bzero(&_connaddr, sizeof(_connaddr));

//忽略一些信号 SIGHUP, SIGPIPE

//SIGPIPE:如果客户端关闭,服务端再次write就会产生

//SIGHUP:如果terminal关闭,会给当前进程发送该信号

if (signal(SIGHUP, SIG_IGN) == SIG_ERR) {

fprintf(stderr, "signal ignore SIGHUP\n");

}

if (signal(SIGPIPE, SIG_IGN) == SIG_ERR) {

fprintf(stderr, "signal ignore SIGPIPE\n");

}

//1. 创建socket

_sockfd = socket(AF_INET, SOCK_STREAM /*| SOCK_NONBLOCK*/ | SOCK_CLOEXEC, IPPROTO_TCP);

if (_sockfd == -1) {

fprintf(stderr, "tcp_server::socket()\n");

exit(1);

}

//2 初始化地址

struct sockaddr_in server_addr;

bzero(&server_addr, sizeof(server_addr));

server_addr.sin_family = AF_INET;

inet_aton(ip, &server_addr.sin_addr);

server_addr.sin_port = htons(port);

//2-1可以多次监听,设置REUSE属性

int op = 1;

if (setsockopt(_sockfd, SOL_SOCKET, SO_REUSEADDR, &op, sizeof(op)) < 0) {

fprintf(stderr, "setsocketopt SO_REUSEADDR\n");

}

//3 绑定端口

if (bind(_sockfd, (const struct sockaddr*)&server_addr, sizeof(server_addr)) < 0) {

fprintf(stderr, "bind error\n");

exit(1);

}

//4 监听ip端口

if (listen(_sockfd, 500) == -1) {

fprintf(stderr, "listen error\n");

exit(1);

}

// ============= 新增 ======================

//5 将_sockfd添加到event_loop中

_loop = loop;

//6 注册_socket读事件-->accept处理

_loop->add_io_event(_sockfd, accept_callback, EPOLLIN, this);

// ============= 新增 ======================

}

- 修改do_accept()方法

lars_reactor/src/tcp_server.cpp

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <strings.h>

#include <unistd.h>

#include <signal.h>

#include <sys/types.h> /* See NOTES */

#include <sys/socket.h>

#include <arpa/inet.h>

#include <errno.h>

#include "tcp_server.h"

#include "reactor_buf.h"

//临时的收发消息

struct message{

char data[m4K];

char len;

};

struct message msg;

void server_rd_callback(event_loop *loop, int fd, void *args);

void server_wt_callback(event_loop *loop, int fd, void *args);

//...省略其他代码

//...省略其他代码

//server read_callback

void server_rd_callback(event_loop *loop, int fd, void *args)

{

int ret = 0;

struct message *msg = (struct message*)args;

input_buf ibuf;

ret = ibuf.read_data(fd);

if (ret == -1) {

fprintf(stderr, "ibuf read_data error\n");

//删除事件

loop->del_io_event(fd);

//对端关闭

close(fd);

return;

}

if (ret == 0) {

//删除事件

loop->del_io_event(fd);

//对端关闭

close(fd);

return ;

}

printf("ibuf.length() = %d\n", ibuf.length());

//将读到的数据放在msg中

msg->len = ibuf.length();

bzero(msg->data, msg->len);

memcpy(msg->data, ibuf.data(), msg->len);

ibuf.pop(msg->len);

ibuf.adjust();

printf("recv data = %s\n", msg->data);

//删除读事件,添加写事件

loop->del_io_event(fd, EPOLLIN);

loop->add_io_event(fd, server_wt_callback, EPOLLOUT, msg);

}

//server write_callback

void server_wt_callback(event_loop *loop, int fd, void *args)

{

struct message *msg = (struct message*)args;

output_buf obuf;

//回显数据

obuf.send_data(msg->data, msg->len);

while(obuf.length()) {

int write_ret = obuf.write2fd(fd);

if (write_ret == -1) {

fprintf(stderr, "write connfd error\n");

return;

}

else if(write_ret == 0) {

//不是错误,表示此时不可写

break;

}

}

//删除写事件,添加读事件

loop->del_io_event(fd, EPOLLOUT);

loop->add_io_event(fd, server_rd_callback, EPOLLIN, msg);

}

//...省略其他代码

//...省略其他代码

//开始提供创建链接服务

void tcp_server::do_accept()

{

int connfd;

while(true) {

//accept与客户端创建链接

printf("begin accept\n");

connfd = accept(_sockfd, (struct sockaddr*)&_connaddr, &_addrlen);

if (connfd == -1) {

if (errno == EINTR) {

fprintf(stderr, "accept errno=EINTR\n");

continue;

}

else if (errno == EMFILE) {

//建立链接过多,资源不够

fprintf(stderr, "accept errno=EMFILE\n");

}

else if (errno == EAGAIN) {

fprintf(stderr, "accept errno=EAGAIN\n");

break;

}

else {

fprintf(stderr, "accept error");

exit(1);

}

}

else {

//accept succ!

// ============= 新增 ======================

this->_loop->add_io_event(connfd, server_rd_callback, EPOLLIN, &msg);

break;

// ============= 新增 ======================

}

}

}

//...省略其他代码

//...省略其他代码

4.4 完成Lars Reactor V0.3开发

我们将lars_reactor/example/lars_reactor_0.2的代码复制一份到 lars_reactor/example/lars_reactor_0.3中。

lars_reactor/example/lars_reactor_0.3/lars_reactor.cpp

#include "tcp_server.h"

int main()

{

event_loop loop;

tcp_server server(&loop, "127.0.0.1", 7777);

loop.event_process();

return 0;

}

编译。

启动服务器

$ ./lars_reactor

分别启动2个客户端

client1

$ nc 127.0.0.1 7777

hello Iam client1

hello Iam client1 回显

client2

$ nc 127.0.0.1 7777

hello Iam client2

hello Iam client2 回显

服务端打印

$ ./lars_reactor

begin accept

ibuf.length() = 18

recv data = hello Iam client1

begin accept

ibuf.length() = 18

recv data = hello Iam client2

目前我们已经成功将event_loop机制加入到reactor中了,接下来继续添加功能。

5) tcp链接与Message消息封装

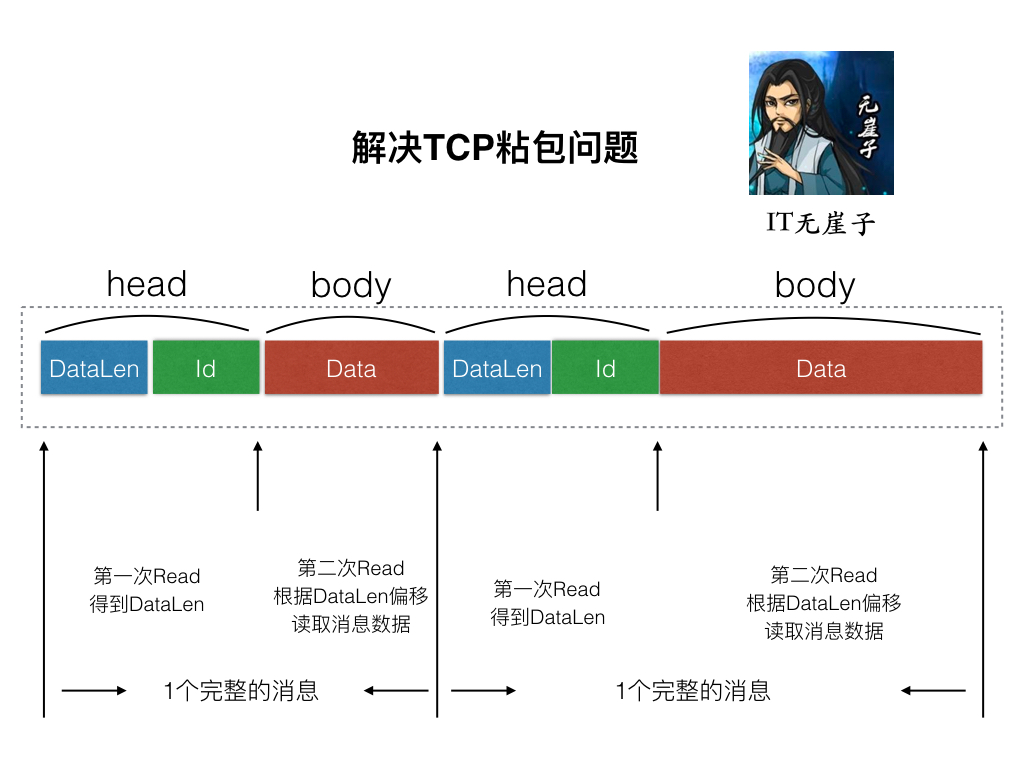

好了,现在我们来将服务器的连接做一个简单的封装,在这之前,我们要将我我们所发的数据做一个规定,采用TLV的格式,来进行封装。目的是解决TCP传输的粘包问题。

5.1 Message消息封装

先创建一个message.h头文件

lars_reactor/include/message.h

#pragma once

//解决tcp粘包问题的消息头

struct msg_head

{

int msgid;

int msglen;

};

//消息头的二进制长度,固定数

#define MESSAGE_HEAD_LEN 8

//消息头+消息体的最大长度限制

#define MESSAGE_LENGTH_LIMIT (65535 - MESSAGE_HEAD_LEN)

接下来我们每次在server和 client之间传递数据的时候,都发送这种数据格式的头再加上后面的数据内容即可。

5.2 创建一个tcp_conn连接类

lars_reactor/include/tcp_conn.h

#pragma once

#include "reactor_buf.h"

#include "event_loop.h"

//一个tcp的连接信息

class tcp_conn

{

public:

//初始化tcp_conn

tcp_conn(int connfd, event_loop *loop);

//处理读业务

void do_read();

//处理写业务

void do_write();

//销毁tcp_conn

void clean_conn();

//发送消息的方法

int send_message(const char *data, int msglen, int msgid);

private:

//当前链接的fd

int _connfd;

//该连接归属的event_poll

event_loop *_loop;

//输出buf

output_buf obuf;

//输入buf

input_buf ibuf;

};

简单说明一下里面的成员和方法:

成员:

_connfd:server刚刚accept成功的套接字

_loop:当前链接所绑定的事件触发句柄.

obuf:链接输出缓冲,向对端写数据

ibuf:链接输入缓冲,从对端读数据

方法:

tcp_client():构造,主要在里面实现初始化及创建链接链接的connect过程。

do_read():读数据处理业务,主要是EPOLLIN事件触发。

do_write():写数据处理业务,主要是EPOLLOUT事件触发。

clean_conn():清空链接资源。

send_message():将消息打包成TLV格式发送给对端。

接下来,实现以下tcp_conn类.

lars_reactor/src/tcp_conn.cpp

#include <unistd.h>

#include <fcntl.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <netinet/tcp.h>

#include <string.h>

#include "tcp_conn.h"

#include "message.h"

//回显业务

void callback_busi(const char *data, uint32_t len, int msgid, void *args, tcp_conn *conn)

{

conn->send_message(data, len, msgid);

}

//连接的读事件回调

static void conn_rd_callback(event_loop *loop, int fd, void *args)

{

tcp_conn *conn = (tcp_conn*)args;

conn->do_read();

}

//连接的写事件回调

static void conn_wt_callback(event_loop *loop, int fd, void *args)

{

tcp_conn *conn = (tcp_conn*)args;

conn->do_write();

}

//初始化tcp_conn

tcp_conn::tcp_conn(int connfd, event_loop *loop)

{

_connfd = connfd;

_loop = loop;

//1. 将connfd设置成非阻塞状态

int flag = fcntl(_connfd, F_GETFL, 0);

fcntl(_connfd, F_SETFL, O_NONBLOCK|flag);

//2. 设置TCP_NODELAY禁止做读写缓存,降低小包延迟

int op = 1;

setsockopt(_connfd, IPPROTO_TCP, TCP_NODELAY, &op, sizeof(op));//need netinet/in.h netinet/tcp.h

//3. 将该链接的读事件让event_loop监控

_loop->add_io_event(_connfd, conn_rd_callback, EPOLLIN, this);

//4 将该链接集成到对应的tcp_server中

//TODO

}

//处理读业务

void tcp_conn::do_read()

{

//1. 从套接字读取数据

int ret = ibuf.read_data(_connfd);

if (ret == -1) {

fprintf(stderr, "read data from socket\n");

this->clean_conn();

return ;

}

else if ( ret == 0) {

//对端正常关闭

printf("connection closed by peer\n");

clean_conn();

return ;

}

//2. 解析msg_head数据

msg_head head;

//[这里用while,可能一次性读取多个完整包过来]

while (ibuf.length() >= MESSAGE_HEAD_LEN) {

//2.1 读取msg_head头部,固定长度MESSAGE_HEAD_LEN

memcpy(&head, ibuf.data(), MESSAGE_HEAD_LEN);

if(head.msglen > MESSAGE_LENGTH_LIMIT || head.msglen < 0) {

fprintf(stderr, "data format error, need close, msglen = %d\n", head.msglen);

this->clean_conn();

break;

}

if (ibuf.length() < MESSAGE_HEAD_LEN + head.msglen) {

//缓存buf中剩余的数据,小于实际上应该接受的数据

//说明是一个不完整的包,应该抛弃

break;

}

//2.2 再根据头长度读取数据体,然后针对数据体处理 业务

//TODO 添加包路由模式

//头部处理完了,往后偏移MESSAGE_HEAD_LEN长度

ibuf.pop(MESSAGE_HEAD_LEN);

//处理ibuf.data()业务数据

printf("read data: %s\n", ibuf.data());

//回显业务

callback_busi(ibuf.data(), head.msglen, head.msgid, NULL, this);

//消息体处理完了,往后便宜msglen长度

ibuf.pop(head.msglen);

}

ibuf.adjust();

return ;

}

//处理写业务

void tcp_conn::do_write()

{

//do_write是触发玩event事件要处理的事情,

//应该是直接将out_buf力度数据io写会对方客户端

//而不是在这里组装一个message再发

//组装message的过程应该是主动调用

//只要obuf中有数据就写

while (obuf.length()) {

int ret = obuf.write2fd(_connfd);

if (ret == -1) {

fprintf(stderr, "write2fd error, close conn!\n");

this->clean_conn();

return ;

}

if (ret == 0) {

//不是错误,仅返回0表示不可继续写

break;

}

}

if (obuf.length() == 0) {

//数据已经全部写完,将_connfd的写事件取消掉

_loop->del_io_event(_connfd, EPOLLOUT);

}

return ;

}

//发送消息的方法

int tcp_conn::send_message(const char *data, int msglen, int msgid)

{

printf("server send_message: %s:%d, msgid = %d\n", data, msglen, msgid);

bool active_epollout = false;

if(obuf.length() == 0) {

//如果现在已经数据都发送完了,那么是一定要激活写事件的

//如果有数据,说明数据还没有完全写完到对端,那么没必要再激活等写完再激活

active_epollout = true;

}

//1 先封装message消息头

msg_head head;

head.msgid = msgid;

head.msglen = msglen;

//1.1 写消息头

int ret = obuf.send_data((const char *)&head, MESSAGE_HEAD_LEN);

if (ret != 0) {

fprintf(stderr, "send head error\n");

return -1;

}

//1.2 写消息体

ret = obuf.send_data(data, msglen);

if (ret != 0) {

//如果写消息体失败,那就回滚将消息头的发送也取消

obuf.pop(MESSAGE_HEAD_LEN);

return -1;

}

if (active_epollout == true) {

//2. 激活EPOLLOUT写事件

_loop->add_io_event(_connfd, conn_wt_callback, EPOLLOUT, this);

}

return 0;

}

//销毁tcp_conn

void tcp_conn::clean_conn()

{

//链接清理工作

//1 将该链接从tcp_server摘除掉

//TODO

//2 将该链接从event_loop中摘除

_loop->del_io_event(_connfd);

//3 buf清空

ibuf.clear();

obuf.clear();

//4 关闭原始套接字

int fd = _connfd;

_connfd = -1;

close(fd);

}

具体每个方法的实现,都很清晰。其中conn_rd_callback()和conn_wt_callback()是注册读写事件的回调函数,设置为static是因为函数类型没有this指针。在里面分别再调用do_read()和do_write()方法。

5.3 修正tcp_server对accept之后的处理方法

lars_reactor/src/tcp_server.cpp

//...

//开始提供创建链接服务

void tcp_server::do_accept()

{

int connfd;

while(true) {

//accept与客户端创建链接

printf("begin accept\n");

connfd = accept(_sockfd, (struct sockaddr*)&_connaddr, &_addrlen);

if (connfd == -1) {

if (errno == EINTR) {

fprintf(stderr, "accept errno=EINTR\n");

continue;

}

else if (errno == EMFILE) {

//建立链接过多,资源不够

fprintf(stderr, "accept errno=EMFILE\n");

}

else if (errno == EAGAIN) {

fprintf(stderr, "accept errno=EAGAIN\n");

break;

}

else {

fprintf(stderr, "accept error");

exit(1);

}

}

else {

//accept succ!

// ============= 将之前的触发回调的删掉,改成如下====

tcp_conn *conn = new tcp_conn(connfd, _loop);

if (conn == NULL) {

fprintf(stderr, "new tcp_conn error\n");

exit(1);

}

// ============================================

printf("get new connection succ!\n");

break;

}

}

}

//...

这样,每次accept成功之后,创建一个与当前客户端套接字绑定的tcp_conn对象。在构造里就完成了基本的对于EPOLLIN事件的监听和回调动作.

现在可以先编译一下,保证没有语法错误,但是如果想测试,就不能够使用nc指令测试了,因为现在服务端只能够接收我们自定义的TLV格式的报文。那么我们需要自己写一个客户端来完成基本的测试。

6) tcp客户端触发模型

我们可以给客户端添加触发模型。同时也提供一系列的接口供开发者写客户端应用程序来使用。

6.1 tcp_client类设计

lars_reactor/include/tcp_client.h

#pragma once

#include "io_buf.h"

#include "event_loop.h"

#include "message.h"

#include <sys/types.h>

#include <sys/socket.h>

#include <netinet/in.h>

#include <arpa/inet.h>

class tcp_client

{

public:

//初始化客户端套接字

tcp_client(event_loop *loop, const char *ip, unsigned short port, const char *name);

//发送message方法

int send_message(const char *data, int msglen, int msgid);

//创建链接

void do_connect();

//处理读业务

int do_read();

//处理写业务

int do_write();

//释放链接资源

void clean_conn();

~tcp_client();

//设置业务处理回调函数

void set_msg_callback(msg_callback *msg_cb)

{

this->_msg_callback = msg_cb;

}

bool connected; //链接是否创建成功

//server端地址

struct sockaddr_in _server_addr;

io_buf _obuf;

io_buf _ibuf;

private:

int _sockfd;

socklen_t _addrlen;

//客户端的事件处理机制

event_loop* _loop;

//当前客户端的名称 用户记录日志

const char *_name;

msg_callback *_msg_callback;

};

这里注意的是,tcp_client并不是tcp_server的一部分,而是单纯为写客户端提供的接口。所以这里也需要实现一套对读写事件处理的业务。 这里使用的读写缓冲是原始的io_buf,并不是服务器封装好的reactor_buf原因是后者是转为server做了一层封装,io_buf的基本方法比较全。

关键成员:

_sockfd:当前客户端套接字。

_server_addr: 链接的服务端的IP地址。

_loop: 客户端异步触发事件机制event_loop句柄。

_msg_callback: 当前客户端处理服务端的回调业务。

connected:是否已经成功connect服务端的标致。

方法:

tcp_client():构造函数,主要是在里面完成基本的套接字初始化及connect操作.

do_connect():创建链接

do_read():处理链接的读业务。

do_write():处理链接的写业务。

clean_conn():清空链接资源。

6.2 创建链接

lars_reactor/src/tcp_client.cpp

tcp_client::tcp_client(event_loop *loop, const char *ip, unsigned short port, const char *name):

_ibuf(4194304),

_obuf(4194304)

{

_sockfd = -1;

_msg_callback = NULL;

_name = name;

_loop = loop;

bzero(&_server_addr, sizeof(_server_addr));

_server_addr.sin_family = AF_INET;

inet_aton(ip, &_server_addr.sin_addr);

_server_addr.sin_port = htons(port);

_addrlen = sizeof(_server_addr);

this->do_connect();

}

这里初始化tcp_client链接信息,然后调用do_connect()创建链接.

lars_reactor/src/tcp_client.cpp

//创建链接

void tcp_client::do_connect()

{

if (_sockfd != -1) {

close(_sockfd);

}

//创建套接字

_sockfd = socket(AF_INET, SOCK_STREAM | SOCK_CLOEXEC | SOCK_NONBLOCK, IPPROTO_TCP);

if (_sockfd == -1) {

fprintf(stderr, "create tcp client socket error\n");

exit(1);

}

int ret = connect(_sockfd, (const struct sockaddr*)&_server_addr, _addrlen);

if (ret == 0) {

//链接创建成功

connected = true;

//注册读回调

_loop->add_io_event(_sockfd, read_callback, EPOLLIN, this);

//如果写缓冲去有数据,那么也需要触发写回调

if (this->_obuf.length != 0) {

_loop->add_io_event(_sockfd, write_callback, EPOLLOUT, this);

}

printf("connect %s:%d succ!\n", inet_ntoa(_server_addr.sin_addr), ntohs(_server_addr.sin_port));

}

else {

if(errno == EINPROGRESS) {

//fd是非阻塞的,可能会出现这个错误,但是并不表示链接创建失败

//如果fd是可写状态,则为链接是创建成功的.

fprintf(stderr, "do_connect EINPROGRESS\n");

//让event_loop去触发一个创建判断链接业务 用EPOLLOUT事件立刻触发

_loop->add_io_event(_sockfd, connection_delay, EPOLLOUT, this);

}

else {

fprintf(stderr, "connection error\n");

exit(1);

}

}

}

6.3 有关非阻塞客户端socket创建链接问题

这里转载一篇文章,是有关非阻塞套接字,connect返回-1,并且errno是EINPROGRESS的情况。因为我们的client是采用event_loop形式,socket需要被设置为非阻塞。所以需要针对这个情况做处理。下面是说明。

客户端测试程序时,由于出现很多客户端,经过connect成功后,代码卡在recv系统调用中,后来发现可能是由于socket默认是阻塞模式,所以会令很多客户端链接处于链接却不能传输数据状态。

后来修改socket为非阻塞模式,但在connect的时候,发现返回值为-1,刚开始以为是connect出现错误,但在服务器上看到了链接是ESTABLISED状态。证明链接是成功的

但为什么会出现返回值是-1呢? 经过查询资料,以及看stevens的APUE,也发现有这么一说。

当connect在非阻塞模式下,会出现返回-1值,错误码是EINPROGRESS,但如何判断connect是联通的呢?stevens书中说明要在connect后,继续判断该socket是否可写?

若可写,则证明链接成功。

如何判断可写,有2种方案,一种是select判断是否可写,二用poll模型。

select:

int CheckConnect(int iSocket)

{

fd_set rset;

FD_ZERO(&rset);

FD_SET(iSocket, &rset);

timeval tm;

tm. tv_sec = 0;

tm.tv_usec = 0;

if ( select(iSocket + 1, NULL, &rset, NULL, &tval) <= 0)

{

close(iSocket);

return -1;

}

if (FD_ISSET(iSocket, &rset))

{

int err = -1;

socklen_t len = sizeof(int);

if ( getsockopt(iSocket, SOL_SOCKET, SO_ERROR ,&err, &len) < 0 )

{

close(iSocket);

printf("errno:%d %s\n", errno, strerror(errno));

return -2;

}

if (err)

{

errno = err;

close(iSocket);

return -3;

}

}

return 0;

}

poll:

int CheckConnect(int iSocket) {

struct pollfd fd;

int ret = 0;

socklen_t len = 0;

fd.fd = iSocket;

fd.events = POLLOUT;

while ( poll (&fd, 1, -1) == -1 ) {

if( errno != EINTR ){

perror("poll");

return -1;

}

}

len = sizeof(ret);

if ( getsockopt (iSocket, SOL_SOCKET, SO_ERROR, &ret, &len) == -1 ) {

perror("getsockopt");

return -1;

}

if(ret != 0) {

fprintf (stderr, "socket %d connect failed: %s\n",

iSocket, strerror (ret));

return -1;

}

return 0;

}

6.3 针对EINPROGRESS的连接创建处理

看上面do_connect()的代码其中一部分:

if(errno == EINPROGRESS) {

//fd是非阻塞的,可能会出现这个错误,但是并不表示链接创建失败

//如果fd是可写状态,则为链接是创建成功的.

fprintf(stderr, "do_connect EINPROGRESS\n");

//让event_loop去触发一个创建判断链接业务 用EPOLLOUT事件立刻触发

_loop->add_io_event(_sockfd, connection_delay, EPOLLOUT, this);

}

这里是又触发一个写事件,直接让程序流程跳转到connection_delay()方法.那么我们需要在里面判断链接是否已经判断成功,并且做出一定的创建成功之后的业务动作。

lars_reactor/src/tcp_client.cpp

//判断链接是否是创建链接,主要是针对非阻塞socket 返回EINPROGRESS错误

static void connection_delay(event_loop *loop, int fd, void *args)

{

tcp_client *cli = (tcp_client*)args;

loop->del_io_event(fd);

int result = 0;

socklen_t result_len = sizeof(result);

getsockopt(fd, SOL_SOCKET, SO_ERROR, &result, &result_len);

if (result == 0) {

//链接是建立成功的

cli->connected = true;

printf("connect %s:%d succ!\n", inet_ntoa(cli->_server_addr.sin_addr), ntohs(cli->_server_addr.sin_port));

//建立连接成功之后,主动发送send_message

const char *msg = "hello lars!";

int msgid = 1;

cli->send_message(msg, strlen(msg), msgid);

loop->add_io_event(fd, read_callback, EPOLLIN, cli);

if (cli->_obuf.length != 0) {

//输出缓冲有数据可写

loop->add_io_event(fd, write_callback, EPOLLOUT, cli);

}

}

else {

//链接创建失败

fprintf(stderr, "connection %s:%d error\n", inet_ntoa(cli->_server_addr.sin_addr), ntohs(cli->_server_addr.sin_port));

}

}

这是一个事件回调,所以用的是static方法而不是成员方法。首先是利用getsockopt判断链接是否创建成功,如果成功,那么 我们当前这个版本的客户端是直接写死主动调用send_message()方法发送给服务端一个hello lars!字符串。然后直接交给我们的read_callback()方法处理,当然如果写缓冲有数据,我们也会触发写的write_callback()方法。

接下来,看看这两个callback以及send_message是怎么实现的。

callback

lars_reactor/src/tcp_client.cpp

static void write_callback(event_loop *loop, int fd, void *args)

{

tcp_client *cli = (tcp_client *)args;

cli->do_write();

}

static void read_callback(event_loop *loop, int fd, void *args)

{

tcp_client *cli = (tcp_client *)args;

cli->do_read();

}

//处理读业务

int tcp_client::do_read()

{

//确定已经成功建立连接

assert(connected == true);

// 1. 一次性全部读取出来

//得到缓冲区里有多少字节要被读取,然后将字节数放入b里面。

int need_read = 0;

if (ioctl(_sockfd, FIONREAD, &need_read) == -1) {

fprintf(stderr, "ioctl FIONREAD error");

return -1;

}

//确保_buf可以容纳可读数据

assert(need_read <= _ibuf.capacity - _ibuf.length);

int ret;

do {

ret = read(_sockfd, _ibuf.data + _ibuf.length, need_read);

} while(ret == -1 && errno == EINTR);

if (ret == 0) {

//对端关闭

if (_name != NULL) {

printf("%s client: connection close by peer!\n", _name);

}

else {

printf("client: connection close by peer!\n");

}

clean_conn();

return -1;

}

else if (ret == -1) {

fprintf(stderr, "client: do_read() , error\n");

clean_conn();

return -1;

}

assert(ret == need_read);

_ibuf.length += ret;

//2. 解包

msg_head head;

int msgid, length;

while (_ibuf.length >= MESSAGE_HEAD_LEN) {

memcpy(&head, _ibuf.data + _ibuf.head, MESSAGE_HEAD_LEN);

msgid = head.msgid;

length = head.msglen;

/*

if (length + MESSAGE_HEAD_LEN < _ibuf.length) {

break;

}

*/

//头部读取完毕

_ibuf.pop(MESSAGE_HEAD_LEN);

//3. 交给业务函数处理

if (_msg_callback != NULL) {

this->_msg_callback(_ibuf.data + _ibuf.head, length, msgid, this, NULL);

}

//数据区域处理完毕

_ibuf.pop(length);

}

//重置head指针

_ibuf.adjust();

return 0;

}

//处理写业务

int tcp_client::do_write()

{

//数据有长度,切头部索引是起始位置

assert(_obuf.head == 0 && _obuf.length);

int ret;

while (_obuf.length) {

//写数据

do {

ret = write(_sockfd, _obuf.data, _obuf.length);

} while(ret == -1 && errno == EINTR);//非阻塞异常继续重写

if (ret > 0) {

_obuf.pop(ret);

_obuf.adjust();

}

else if (ret == -1 && errno != EAGAIN) {

fprintf(stderr, "tcp client write \n");

this->clean_conn();

}

else {

//出错,不能再继续写

break;

}

}

if (_obuf.length == 0) {

//已经写完,删除写事件

printf("do write over, del EPOLLOUT\n");

this->_loop->del_io_event(_sockfd, EPOLLOUT);

}

return 0;

}

//释放链接资源,重置连接

void tcp_client::clean_conn()

{

if (_sockfd != -1) {

printf("clean conn, del socket!\n");

_loop->del_io_event(_sockfd);

close(_sockfd);

}

connected = false;

//重新连接

this->do_connect();

}

tcp_client::~tcp_client()

{

close(_sockfd);

}

这里是基本的读数据和写数据的处理业务实现。我们重点看do_read()方法,里面有段代码:

//3. 交给业务函数处理

if (_msg_callback != NULL) {

this->_msg_callback(_ibuf.data + _ibuf.head, length, msgid, this, NULL);

}

是将我们从服务端读取到的代码,交给了_msg_callback()方法来处理的,这个实际上是用户开发者自己在业务上注册的回调业务函数。在tcp_client.h中我们已经提供了set_msg_callback暴露给开发者注册使用。

send_message

lars_reactor/src/tcp_client.cpp

//主动发送message方法

int tcp_client::send_message(const char *data, int msglen, int msgid)

{

if (connected == false) {

fprintf(stderr, "no connected , send message stop!\n");

return -1;

}

//是否需要添加写事件触发

//如果obuf中有数据,没必要添加,如果没有数据,添加完数据需要触发

bool need_add_event = (_obuf.length == 0) ? true:false;

if (msglen + MESSAGE_HEAD_LEN > this->_obuf.capacity - _obuf.length) {

fprintf(stderr, "No more space to Write socket!\n");

return -1;

}

//封装消息头

msg_head head;

head.msgid = msgid;

head.msglen = msglen;

memcpy(_obuf.data + _obuf.length, &head, MESSAGE_HEAD_LEN);

_obuf.length += MESSAGE_HEAD_LEN;

memcpy(_obuf.data + _obuf.length, data, msglen);

_obuf.length += msglen;

if (need_add_event) {

_loop->add_io_event(_sockfd, write_callback, EPOLLOUT, this);

}

return 0;

}

将发送的数据写给obuf,然后出发write_callback将obuf的数据传递给对方服务端。

6.4 完成Lars Reactor V0.4开发

好了,现在我们框架部分已经完成,接下来我们就要实现一个serverapp 和 一个clientapp来进行测试.

我们创建example/lars_reactor_0.4文件夹。

Makefile

CXX=g++

CFLAGS=-g -O2 -Wall -fPIC -Wno-deprecated

INC=-I../../include

LIB=-L../../lib -llreactor -lpthread

OBJS = $(addsuffix .o, $(basename $(wildcard *.cc)))

all:

$(CXX) -o server $(CFLAGS) server.cpp $(INC) $(LIB)

$(CXX) -o client $(CFLAGS) client.cpp $(INC) $(LIB)

clean:

-rm -f *.o server client

服务端代码:

server.cpp

#include "tcp_server.h"

int main()

{

event_loop loop;

tcp_server server(&loop, "127.0.0.1", 7777);

loop.event_process();

return 0;

}

客户端代码:

client.cpp

#include "tcp_client.h"

#include <stdio.h>

#include <string.h>

//客户端业务

void busi(const char *data, uint32_t len, int msgid, tcp_client *conn, void *user_data)

{

//得到服务端回执的数据

printf("recv server: [%s]\n", data);

printf("msgid: [%d]\n", msgid);

printf("len: [%d]\n", len);

}

int main()

{

event_loop loop;

//创建tcp客户端

tcp_client client(&loop, "127.0.0.1", 7777, "clientv0.4");

//注册回调业务

client.set_msg_callback(busi);

//开启事件监听

loop.event_process();

return 0;

}

编译并分别启动server 和client

服务端输出:

$ ./server

begin accept

get new connection succ!

read data: hello lars!

server send_message: hello lars!:11, msgid = 1

客户端输出:

$ ./client

do_connect EINPROGRESS

connect 127.0.0.1:7777 succ!

do write over, del EPOLLOUT

recv server: [hello lars!]

msgid: [1]

len: [11]

现在客户端已经成功的发送数据给服务端,并且回显的数据也直接被客户端解析,我们的框架到现在就可以做一个基本的客户端和服务端的完成了,但是还差很多,接下来我们继续优化。

7) tcp_server端集成tcp_conn链接属性

现在我们已经把server端所创建的套接字包装成了tcp_conn类,那么我们就可以对他们进行一定的管理,比如限制最大的连接数量等等。

7.1 定义链接管理相关属性

lars_reactor/include/tcp_server.h

#pragma once

#include <netinet/in.h>

#include "event_loop.h"

#include "tcp_conn.h"

class tcp_server

{

public:

//server的构造函数

tcp_server(event_loop* loop, const char *ip, uint16_t port);

//开始提供创建链接服务

void do_accept();

//链接对象释放的析构

~tcp_server();

private:

//基础信息

int _sockfd; //套接字

struct sockaddr_in _connaddr; //客户端链接地址

socklen_t _addrlen; //客户端链接地址长度

//event_loop epoll事件机制

event_loop* _loop;

//---- 客户端链接管理部分-----

public:

static void increase_conn(int connfd, tcp_conn *conn); //新增一个新建的连接

static void decrease_conn(int connfd); //减少一个断开的连接

static void get_conn_num(int *curr_conn); //得到当前链接的刻度

static tcp_conn **conns; //全部已经在线的连接信息

private:

//TODO

//从配置文件中读取

#define MAX_CONNS 2

static int _max_conns; //最大client链接个数

static int _curr_conns; //当前链接刻度

static pthread_mutex_t _conns_mutex; //保护_curr_conns刻度修改的锁

};

这里解释一下关键成员

conns:这个是记录已经建立成功的全部链接的struct tcp_conn*数组。_curr_conns:表示当前链接个数,其中increase_conn,decrease_conn,get_conn_num三个方法分别是对链接个数增加、减少、和获取。_max_conns:限制的最大链接数量。_conns_mutex:保护_curr_conns的锁。

好了,我们首先首先将这些静态变量初始化,并且对函数见一些定义:

lars_reactor/src/tcp_server.cpp

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <strings.h>

#include <unistd.h>

#include <signal.h>

#include <sys/types.h> /* See NOTES */

#include <sys/socket.h>

#include <arpa/inet.h>

#include <errno.h>

#include "tcp_server.h"

#include "tcp_conn.h"

#include "reactor_buf.h"

// ==== 链接资源管理 ====

//全部已经在线的连接信息

tcp_conn ** tcp_server::conns = NULL;

//最大容量链接个数;

int tcp_server::_max_conns = 0;

//当前链接刻度

int tcp_server::_curr_conns = 0;

//保护_curr_conns刻度修改的锁

pthread_mutex_t tcp_server::_conns_mutex = PTHREAD_MUTEX_INITIALIZER;

//新增一个新建的连接

void tcp_server::increase_conn(int connfd, tcp_conn *conn)

{

pthread_mutex_lock(&_conns_mutex);

conns[connfd] = conn;

_curr_conns++;

pthread_mutex_unlock(&_conns_mutex);

}

//减少一个断开的连接

void tcp_server::decrease_conn(int connfd)

{

pthread_mutex_lock(&_conns_mutex);

conns[connfd] = NULL;

_curr_conns--;

pthread_mutex_unlock(&_conns_mutex);

}

//得到当前链接的刻度

void tcp_server::get_conn_num(int *curr_conn)

{

pthread_mutex_lock(&_conns_mutex);

*curr_conn = _curr_conns;

pthread_mutex_unlock(&_conns_mutex);

}

//...

//...

//...

7.2 创建链接集合初始化

我们在初始化tcp_server的同时也将conns初始化.

lars_reactor/src/tcp_server.cpp

//server的构造函数

tcp_server::tcp_server(event_loop *loop, const char *ip, uint16_t port)

{

bzero(&_connaddr, sizeof(_connaddr));

//忽略一些信号 SIGHUP, SIGPIPE

//SIGPIPE:如果客户端关闭,服务端再次write就会产生

//SIGHUP:如果terminal关闭,会给当前进程发送该信号

if (signal(SIGHUP, SIG_IGN) == SIG_ERR) {

fprintf(stderr, "signal ignore SIGHUP\n");

}

if (signal(SIGPIPE, SIG_IGN) == SIG_ERR) {

fprintf(stderr, "signal ignore SIGPIPE\n");

}

//1. 创建socket

_sockfd = socket(AF_INET, SOCK_STREAM /*| SOCK_NONBLOCK*/ | SOCK_CLOEXEC, IPPROTO_TCP);

if (_sockfd == -1) {

fprintf(stderr, "tcp_server::socket()\n");

exit(1);

}

//2 初始化地址

struct sockaddr_in server_addr;

bzero(&server_addr, sizeof(server_addr));

server_addr.sin_family = AF_INET;

inet_aton(ip, &server_addr.sin_addr);

server_addr.sin_port = htons(port);

//2-1可以多次监听,设置REUSE属性

int op = 1;

if (setsockopt(_sockfd, SOL_SOCKET, SO_REUSEADDR, &op, sizeof(op)) < 0) {

fprintf(stderr, "setsocketopt SO_REUSEADDR\n");

}

//3 绑定端口

if (bind(_sockfd, (const struct sockaddr*)&server_addr, sizeof(server_addr)) < 0) {

fprintf(stderr, "bind error\n");

exit(1);

}

//4 监听ip端口

if (listen(_sockfd, 500) == -1) {

fprintf(stderr, "listen error\n");

exit(1);

}

//5 将_sockfd添加到event_loop中

_loop = loop;

//6 ============= 创建链接管理 ===============

_max_conns = MAX_CONNS;

//创建链接信息数组

conns = new tcp_conn*[_max_conns+3];//3是因为stdin,stdout,stderr 已经被占用,再新开fd一定是从3开始,所以不加3就会栈溢出

if (conns == NULL) {

fprintf(stderr, "new conns[%d] error\n", _max_conns);

exit(1);

}

//===========================================

//7 注册_socket读事件-->accept处理

_loop->add_io_event(_sockfd, accept_callback, EPOLLIN, this);

}

这里有一段代码:

conns = new tcp_conn*[_max_conns+3];

其中3是因为我们已经默认打开的stdin,stdout,stderr3个文件描述符,因为我们在conns管理的形式类似一个hash的形式,每个tcp_conn的对应的数组下标就是当前tcp_conn的connfd文件描述符,所以我们应该开辟足够的大的宽度的数组来满足下标要求,所以要多开辟3个。虽然这里0,1,2下标在conns永远用不上。

7.3 创建链接判断链接数量

我们在tcp_server在accept成功之后,判断链接数量,如果满足需求将连接创建起来,并添加到conns中。

lars_reactor/src/tcp_server.cpp

//开始提供创建链接服务

void tcp_server::do_accept()

{

int connfd;

while(true) {

//accept与客户端创建链接

printf("begin accept\n");

connfd = accept(_sockfd, (struct sockaddr*)&_connaddr, &_addrlen);

if (connfd == -1) {

if (errno == EINTR) {

fprintf(stderr, "accept errno=EINTR\n");

continue;

}

else if (errno == EMFILE) {

//建立链接过多,资源不够

fprintf(stderr, "accept errno=EMFILE\n");

}

else if (errno == EAGAIN) {

fprintf(stderr, "accept errno=EAGAIN\n");

break;

}

else {

fprintf(stderr, "accept error");

exit(1);

}

}

else {

// ===========================================

//accept succ!

int cur_conns;

get_conn_num(&cur_conns);

//1 判断链接数量

if (cur_conns >= _max_conns) {

fprintf(stderr, "so many connections, max = %d\n", _max_conns);

close(connfd);

}

else {

tcp_conn *conn = new tcp_conn(connfd, _loop);

if (conn == NULL) {

fprintf(stderr, "new tcp_conn error\n");

exit(1);

}

printf("get new connection succ!\n");

}

// ===========================================

break;

}

}

}

7.4 对链接数量进行内部统计

在tcp_conn创建时,将tcp_server中的conns增加。

lars_reactor/src/tcp_conn.cpp

//初始化tcp_conn

tcp_conn::tcp_conn(int connfd, event_loop *loop)

{

_connfd = connfd;

_loop = loop;

//1. 将connfd设置成非阻塞状态

int flag = fcntl(_connfd, F_GETFL, 0);

fcntl(_connfd, F_SETFL, O_NONBLOCK|flag);

//2. 设置TCP_NODELAY禁止做读写缓存,降低小包延迟

int op = 1;

setsockopt(_connfd, IPPROTO_TCP, TCP_NODELAY, &op, sizeof(op));//need netinet/in.h netinet/tcp.h

//3. 将该链接的读事件让event_loop监控

_loop->add_io_event(_connfd, conn_rd_callback, EPOLLIN, this);

// ============================

//4 将该链接集成到对应的tcp_server中

tcp_server::increase_conn(_connfd, this);

// ============================

}

在tcp_conn销毁时,将tcp_server中的conns减少。

lars_reactor/src/tcp_conn.cpp

//销毁tcp_conn

void tcp_conn::clean_conn()

{

//链接清理工作

//1 将该链接从tcp_server摘除掉

tcp_server::decrease_conn(_connfd);

//2 将该链接从event_loop中摘除

_loop->del_io_event(_connfd);

//3 buf清空

ibuf.clear();

obuf.clear();

//4 关闭原始套接字

int fd = _connfd;

_connfd = -1;

close(fd);

}

7.5 完成Lars Reactor V0.5开发

server和client 应用app端的代码和v0.4一样,这里我们先修改tcp_server中的MAX_CONN宏为

lars_reacotr/include/tcp_server.h

#define MAX_CONNS 2

方便我们测试。这个这个数值是要在配置文件中可以配置的。

我们启动服务端,然后分别启动两个client可以正常连接。

当我们启动第三个就发现已经连接不上。然后server端会打出如下结果.

so many connections, max = 2

8) 消息业务路由分发机制

现在我们发送的消息都是message结构的,有个message头里面其中有两个关键的字段,msgid和msglen,其中加入msgid的意义就是我们可以甄别是哪个消息,从而对这类消息做出不同的业务处理。但是现在我们无论是服务端还是客户端都是写死的两个业务,就是"回显业务",显然这并不满足我们作为服务器框架的需求。我们需要开发者可以注册自己的回调业务。所以我们需要提供一个注册业务的入口,然后在后端根据不同的msgid来激活不同的回调业务函数。

8.1 添加消息分发路由类msg_router

下面我们提供这样一个中转的router模块,在include/message.h添加

lars_reactor/include/message.h

#pragma once

#include <ext/hash_map>

//解决tcp粘包问题的消息头

struct msg_head

{

int msgid;

int msglen;

};

//消息头的二进制长度,固定数

#define MESSAGE_HEAD_LEN 8

//消息头+消息体的最大长度限制

#define MESSAGE_LENGTH_LIMIT (65535 - MESSAGE_HEAD_LEN)

//msg 业务回调函数原型

//===================== 消息分发路由机制 ==================

class tcp_client;

typedef void msg_callback(const char *data, uint32_t len, int msgid, tcp_client *client, void *user_data);

//消息路由分发机制

class msg_router

{

public:

msg_router():_router(),_args() {}

//给一个消息ID注册一个对应的回调业务函数

int register_msg_router(int msgid, msg_callback *msg_cb, void *user_data)

{

if(_router.find(msgid) != _router.end()) {

//该msgID的回调业务已经存在

return -1;

}

_router[msgid] = msg_cb;

_args[msgid] = user_data;

return 0;

}

//调用注册的对应的回调业务函数

void call(int msgid, uint32_t msglen, const char *data, tcp_client *client)

{

//判断msgid对应的回调是否存在

if (_router.find(msgid) == _router.end()) {

fprintf(stderr, "msgid %d is not register!\n", msgid);

return;

}

//直接取出回调函数,执行

msg_callback *callback = _router[msgid];

void *user_data = _args[msgid];

callback(data, msglen, msgid, client, user_data);

}

private:

//针对消息的路由分发,key为msgID, value为注册的回调业务函数

__gnu_cxx::hash_map<int, msg_callback *> _router;

//回调业务函数对应的参数,key为msgID, value为对应的参数

__gnu_cxx::hash_map<int, void *> _args;

};

//===================== 消息分发路由机制 ==================

开发者需要注册一个msg_callback类型的函数,通过msg_router类的register_msg_router()方法来注册,同时通过call()方法来调用。

全部回调业务函数和msgid的对应关系保存在一个hash_map类型的_routermap中,_args保存对应的参数。

但是这里有个小细节需要注意一下,msg_callback的函数类型声明是这样的。

typedef void msg_callback(const char *data, uint32_t len, int msgid, tcp_client *client, void *user_data);

其中这里面第4个参数,只能是tcp_client类型的参数,也就是我们之前的设计的msg_callback只支持tcp_client的消息回调机制,但是很明显我们的需求是不仅是tcp_client要用,tcp_server中的tcp_conn也要用到这个机制,那么很显然这个参数在这就不是很合适,那么如果设定一个形参既能指向tcp_client又能能指向tcp_conn两个类型呢,当然答案就只能是将这两个类抽象出来一层,用父类指针指向子类然后通过多态特性来调用就可以了,所以我们需要先定义一个抽象类。

8.2 链接抽象类创建

经过分析,我们定义如下的抽象类,并提供一些接口。

lars_reactor/include/net_connection.h

#pragma once

/*

*

* 网络通信的抽象类,任何需要进行收发消息的模块,都可以实现该类

*

* */

class net_connection

{

public:

//发送消息的接口

virtual int send_message(const char *data, int datalen, int msgid) = 0;

};

然后让我们tcp_server端的tcp_conn类继承net_connecton, 客户端的tcp_client 继承net_connection

lars_reactor/include/tcp_conn.h

class tcp_conn : public net_connection

{

//...

};

lars_reactor/include/tcp_client.h

class tcp_client : public net_connection

{

//...

}

这样,我们就可以用一个net_connection指针指向这两种不同的对象实例了。

接下来我们将msg_callback回调业务函数类型改成

typedef void msg_callback(const char *data, uint32_t len, int msgid, net_connection *net_conn, void *user_data);

这样这个业务函数就可以支持tcp_conn和tcp_client了。

所以修改之后,我们的msg_router类定义如下:

lars_reactor/include/message.h

//消息路由分发机制

class msg_router

{

public:

msg_router(): {

printf("msg router init ...\n");

}

//给一个消息ID注册一个对应的回调业务函数

int register_msg_router(int msgid, msg_callback *msg_cb, void *user_data)

{

if(_router.find(msgid) != _router.end()) {

//该msgID的回调业务已经存在

return -1;

}

printf("add msg cb msgid = %d\n", msgid);

_router[msgid] = msg_cb;

_args[msgid] = user_data;

return 0;

}

//调用注册的对应的回调业务函数

void call(int msgid, uint32_t msglen, const char *data, net_connection *net_conn)

{

printf("call msgid = %d\n", msgid);

//判断msgid对应的回调是否存在

if (_router.find(msgid) == _router.end()) {

fprintf(stderr, "msgid %d is not register!\n", msgid);

return;

}

//直接取出回调函数,执行

msg_callback *callback = _router[msgid];

void *user_data = _args[msgid];

callback(data, msglen, msgid, net_conn, user_data);

printf("=======\n");

}

private:

//针对消息的路由分发,key为msgID, value为注册的回调业务函数

__gnu_cxx::hash_map<int, msg_callback*> _router;

//回调业务函数对应的参数,key为msgID, value为对应的参数

__gnu_cxx::hash_map<int, void*> _args;

};

8.3 msg_router集成到tcp_server中

A. tcp_server添加msg_router静态成员变量

lars_reactor/include/tcp_server.h

class tcp_server

{

public:

// ...

//---- 消息分发路由 ----

static msg_router router;

// ...

};

同时定义及初始化

lars_reactor/src/tcp_server.cpp

//...

// ==== 消息分发路由 ===

msg_router tcp_server::router;

//...

B. tcp_server提供注册路由方法

lars_reactor/include/tcp_server.c

class tcp_server

{

public:

//...

//注册消息路由回调函数

void add_msg_router(int msgid, msg_callback *cb, void *user_data = NULL) {

router.register_msg_router(msgid, cb, user_data);

}

//...

public:

//全部已经在线的连接信息

//---- 消息分发路由 ----

static msg_router router;

//...

};

C. 修正tcp_conn的do_read改成消息分发

lars_reactor/src/tcp_conn.cpp

//...

//处理读业务

void tcp_conn::do_read()

{

//1. 从套接字读取数据

int ret = ibuf.read_data(_connfd);

if (ret == -1) {

fprintf(stderr, "read data from socket\n");

this->clean_conn();

return ;

}

else if ( ret == 0) {

//对端正常关闭

printf("connection closed by peer\n");

clean_conn();

return ;

}

//2. 解析msg_head数据

msg_head head;

//[这里用while,可能一次性读取多个完整包过来]

while (ibuf.length() >= MESSAGE_HEAD_LEN) {

//2.1 读取msg_head头部,固定长度MESSAGE_HEAD_LEN

memcpy(&head, ibuf.data(), MESSAGE_HEAD_LEN);

if(head.msglen > MESSAGE_LENGTH_LIMIT || head.msglen < 0) {